أسعار NVidia RTX 5080 و RTX 5090 في أستراليا - يوليو 2025

تحديث أسعار GPUs مناسبة للذكاء الاصطناعي - RTX 5080 و RTX 5090

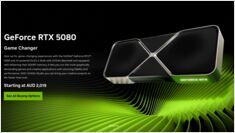

لنقارن الأسعار بين أفضل بطاقات الرسومات الموجهة لمستخدمي الأجهزة النهائية، والتي مناسبة بشكل خاص للنماذج العصبية الكبيرة (LLMs) والأتمتة الذكية بشكل عام. ننظر بالتفصيل إلى أسعار RTX 5080 و RTX 5090. تراجعت الأسعار قليلاً.