降低大语言模型成本:令牌优化策略

通过智能令牌优化,将大语言模型成本降低80%

令牌优化是区分成本效益高的LLM应用与耗费预算的实验的关键技能。

通过智能令牌优化,将大语言模型成本降低80%

令牌优化是区分成本效益高的LLM应用与耗费预算的实验的关键技能。

基于 AWS Kinesis 的事件驱动架构实现可扩展性

AWS Kinesis 已成为构建现代事件驱动微服务架构的基石,它能够以最小的操作开销实现大规模的实时数据处理。

使用 GraphQL BFF 和 Apollo Server 优化前端 API

前端专用后端(BFF) 模式结合 GraphQL 和 Apollo Server 为现代 Web 应用程序创建了强大的架构。

通过自托管的 Nextcloud 云存储掌控您的数据

nextcloud 是领先的开源、自托管云存储和协作平台,让您完全掌控自己的数据。

两个强大的知识管理系统

选择合适的个人知识管理(PKM)工具可以显著影响你的生产力、学习和信息组织方式。让我们来看看Obsidian和LogSeq。

您在自托管人工智能驱动备份中的照片

Immich 是一款革命性的开源、自托管照片和视频管理解决方案,它赋予你对记忆的完全控制权。凭借与 Google Photos 相媲美的功能,包括人工智能驱动的人脸识别、智能搜索和自动手机备份,同时确保你的数据在你自己的服务器上保持私密和安全。

用于搜索、索引和分析的 Elasticsearch 命令

Elasticsearch 是一个基于 Apache Lucene 构建的强大分布式搜索和分析引擎。 这份全面的速查表涵盖了使用 Elasticsearch 集群时的基本命令、最佳实践和快速参考。

使用 pytest 进行 Python 测试,TDD,模拟和覆盖率

单元测试确保你的 Python 代码正常工作,并且随着项目的演进继续正常运行。

本全面指南涵盖了关于 Python 单元测试 的所有内容,从基本概念到高级技术。

使用 Python 示例构建 AI 助手的 MCP 服务器

模型上下文协议(MCP)正在革新AI助手与外部数据源和工具的交互方式。在本指南中,我们将探讨如何构建 MCP 服务器(Python),重点介绍网络搜索和爬取功能的示例。

Ubuntu 键盘快捷键 -> 提升你的工作效率

Ubuntu键盘快捷键是提高生产力和效率的重要工具。无论你是开发者、系统管理员还是高级用户,这些快捷键可能会加快你的工作流程并减少对鼠标的依赖。

用 Python 将 HTML 转换为干净、适合大语言模型处理的 Markdown

将HTML转换为Markdown是现代开发工作流程中的基本任务,特别是在为大型语言模型(LLMs)、文档系统或静态站点生成器(如Hugo)准备网页内容时。

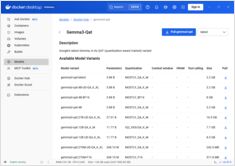

Docker Model Runner 命令快速参考

Docker Model Runner (DMR) 是 Docker 官方用于本地运行 AI 模型的解决方案,于 2025 年 4 月推出。此快速参考提供了所有关键命令、配置和最佳实践的快速查阅。

对比 Docker Model Runner 和 Ollama 本地大语言模型

在本地运行大型语言模型 (LLMs) 已成为隐私保护、成本控制和离线功能的重要趋势。 2025 年 4 月,Docker 推出了 Docker Model Runner (DMR),这是其用于 AI 模型部署的官方解决方案,标志着该领域的重大转变。

部署生产就绪的服务网格 - Istio 与 Linkerd

了解如何使用Istio和Linkerd实现和优化服务网格架构。本指南涵盖部署策略、性能比较、安全配置以及生产环境的最佳实践。

使用 GNOME Boxes 管理 Linux 虚拟机

在当今的计算环境中,虚拟化已成为开发、测试和运行多个操作系统的重要工具。对于寻求一种简单直观方式来管理虚拟机的 Linux 用户来说,GNOME Boxes 是一个轻量且用户友好的选择,它在不牺牲功能性的前提下优先考虑易用性。

拥有21,000+用户的去中心化社交协议,正在重塑在线隐私

这里我们有 Nostr - 一种去中心化的社交协议,它通过抗审查的通信和用户控制的数据,正在挑战大科技公司的主导地位。