为 Docker 模型运行器添加 NVIDIA GPU 支持

启用 NVIDIA CUDA 支持的 Docker 模型运行器的 GPU 加速功能

Docker Model Runner 是 Docker 官方用于本地运行 AI 模型的工具,但

在 Docker Model Runner 中启用 NVidia GPU 加速

需要特定的配置。

启用 NVIDIA CUDA 支持的 Docker 模型运行器的 GPU 加速功能

Docker Model Runner 是 Docker 官方用于本地运行 AI 模型的工具,但

在 Docker Model Runner 中启用 NVidia GPU 加速

需要特定的配置。

零知识证明的隐私保护系统

零知识架构 代表了我们在设计隐私保护系统时的一种范式转变。

完整安全指南 - 静态数据、传输中数据、运行时数据

当数据成为一种宝贵的资产时,保护它从未如此关键。

从信息被创建的那一刻起,到最终被丢弃,

其旅程充满了各种风险——无论是存储、传输,还是主动使用。

对比无头 CMS - 功能、性能与使用场景

选择合适的无头CMS可以决定你的内容管理策略是成功还是失败。

让我们比较三种影响开发人员构建内容驱动型应用的开源解决方案。

使用 Cobra 和 Viper 框架在 Go 中进行 CLI 开发

命令行界面(CLI)应用程序是开发人员、系统管理员和 DevOps 专业人员的重要工具。

有两个 Go 库已成为 Go 中 CLI 开发的默认标准:Cobra 用于命令结构,Viper 用于配置管理。

通过智能令牌优化,将大语言模型成本降低80%

令牌优化是区分成本效益高的LLM应用与耗费预算的实验的关键技能。

基于 AWS Kinesis 的事件驱动架构实现可扩展性

AWS Kinesis 已成为构建现代事件驱动微服务架构的基石,它能够以最小的操作开销实现大规模的实时数据处理。

使用 GraphQL BFF 和 Apollo Server 优化前端 API

前端专用后端(BFF) 模式结合 GraphQL 和 Apollo Server 为现代 Web 应用程序创建了强大的架构。

用于搜索、索引和分析的 Elasticsearch 命令

Elasticsearch 是一个基于 Apache Lucene 构建的强大分布式搜索和分析引擎。 这份全面的速查表涵盖了使用 Elasticsearch 集群时的基本命令、最佳实践和快速参考。

使用 Python 示例构建 AI 助手的 MCP 服务器

模型上下文协议(MCP)正在革新AI助手与外部数据源和工具的交互方式。在本指南中,我们将探讨如何构建 MCP 服务器(Python),重点介绍网络搜索和爬取功能的示例。

Docker Model Runner 命令快速参考

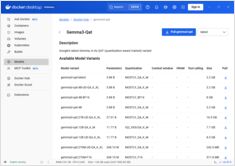

Docker Model Runner (DMR) 是 Docker 官方用于本地运行 AI 模型的解决方案,于 2025 年 4 月推出。此快速参考提供了所有关键命令、配置和最佳实践的快速查阅。

对比 Docker Model Runner 和 Ollama 本地大语言模型

在本地运行大型语言模型 (LLMs) 已成为隐私保护、成本控制和离线功能的重要趋势。 2025 年 4 月,Docker 推出了 Docker Model Runner (DMR),这是其用于 AI 模型部署的官方解决方案,标志着该领域的重大转变。

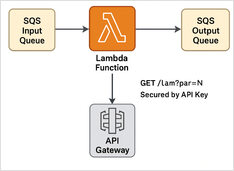

分步示例

在这里,我们有一个 Python Lambda 示例:SQS 消息处理器 + REST API(带 API 密钥保护)+ Terraform 脚本,用于部署无服务器执行。

使用思考型大语言模型的具体示例

在本文中,我们将探讨两种连接您的 Python 应用程序到 Ollama 的方法:1. 通过 HTTP REST API;2. 通过 官方 Ollama Python 库。

略有不同的 API 需要特殊处理。

以下是结构化输出在主流大语言模型(LLM)提供商之间的对比,以及一些Python示例: