Docker Model Runner: Panduan Konfigurasi Ukuran Konteks

Konfigurasikan ukuran konteks di Docker Model Runner dengan solusi kerumitan

Menyetel ukuran konteks di Docker Model Runner lebih kompleks dari yang seharusnya.

Konfigurasikan ukuran konteks di Docker Model Runner dengan solusi kerumitan

Menyetel ukuran konteks di Docker Model Runner lebih kompleks dari yang seharusnya.

Model AI untuk meningkatkan gambar dengan instruksi teks

Black Forest Labs telah merilis FLUX.1-Kontext-dev, sebuah model AI canggih untuk mengubah gambar berdasarkan instruksi teks.

Aktifkan percepatan GPU untuk Docker Model Runner dengan dukungan NVIDIA CUDA

Docker Model Runner adalah alat resmi Docker untuk menjalankan model AI secara lokal, tetapi mengaktifkan percepatan GPU NVidia di Docker Model Runner memerlukan konfigurasi khusus.

Bandingkan headless CMS - fitur, kinerja & kasus penggunaan

Memilih headless CMS yang tepat dapat menentukan keberhasilan atau kegagalan strategi manajemen konten Anda. Mari kita bandingkan tiga solusi open-source yang memengaruhi cara pengembang membangun aplikasi berbasis konten.

Kontrol data Anda dengan penyimpanan awan Nextcloud yang dihosting sendiri

Nextcloud adalah platform penyimpanan dan kolaborasi awan open-source, self-hosted yang terkemuka yang memberi Anda kendali penuh atas data Anda.

Foto-foto Anda pada cadangan berbasis AI yang dhosting sendiri

Immich adalah solusi manajemen foto dan video open-source, self-hosted yang revolusioner yang memberi Anda kendali penuh atas kenangan Anda. Dengan fitur yang sebanding dengan Google Photos - termasuk pengenalan wajah berbasis AI, pencarian cerdas, dan cadangan mobile otomatis - semuanya sambil menjaga data Anda tetap pribadi dan aman di server Anda sendiri.

Perintah Elasticsearch untuk pencarian, indeks, dan analitik

Elasticsearch adalah mesin pencari dan analitik terdistribusi yang kuat yang dibangun berdasarkan Apache Lucene. Cheatsheet komprehensif ini mencakup perintah penting, praktik terbaik, dan referensi cepat untuk bekerja dengan klaster Elasticsearch.

Benchmark GPT-OSS 120b pada tiga platform AI

Saya menemukan beberapa uji kinerja menarik dari GPT-OSS 120b yang berjalan di Ollama di tiga platform berbeda: NVIDIA DGX Spark, Mac Studio, dan RTX 4080. Model GPT-OSS 120b dari perpustakaan Ollama memiliki ukuran 65GB, yang berarti tidak masuk ke dalam 16GB VRAM dari RTX 4080 (atau yang lebih baru RTX 5080).

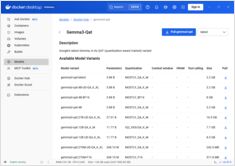

Referensi cepat untuk perintah Docker Model Runner

Docker Model Runner (DMR) adalah solusi resmi Docker untuk menjalankan model AI secara lokal, diperkenalkan pada April 2025. Cheat sheet ini memberikan referensi cepat untuk semua perintah penting, konfigurasi, dan praktik terbaik.

Bandingkan Docker Model Runner dan Ollama untuk LLM lokal

Menjalankan model bahasa besar (LLMs) secara lokal telah semakin populer untuk privasi, kontrol biaya, dan kemampuan offline. Lanskap berubah secara signifikan pada April 2025 ketika Docker memperkenalkan Docker Model Runner (DMR), solusi resmi mereka untuk pengujian model AI.

Manajemen VM sederhana untuk Linux dengan GNOME Boxes

Dalam pemandangan komputasi saat ini, virtualisasi telah menjadi hal yang esensial untuk pengembangan, pengujian, dan menjalankan beberapa sistem operasi. Bagi pengguna Linux yang mencari cara sederhana dan intuitif untuk mengelola mesin virtual, GNOME Boxes menonjol sebagai pilihan ringan dan ramah pengguna yang memprioritaskan kemudahan penggunaan tanpa mengorbankan fungsi.

Instalasi multipass, pengaturan, dan perintah penting

Multipass adalah manajer mesin virtual ringan yang memudahkan pembuatan dan pengelolaan instance Ubuntu di cloud pada Linux, Windows, dan macOS.

Eksplorasi mesin pencari alternatif di luar Google dan Bing

Meskipun Google mendominasi pasar mesin pencari dengan lebih dari 90% pangsa pasar global, terdapat ekosistem yang berkembang dari mesin pencari alternatif yang menawarkan pendekatan berbeda untuk pencarian web.

Chip khusus sedang membuat inferensi AI lebih cepat dan murah.

Masa depan AI bukan hanya tentang model yang lebih cerdas models — tetapi tentang silikon yang lebih cerdas.

Perangkat keras khusus untuk inference LLM sedang mendorong revolusi yang mirip dengan perpindahan penambangan Bitcoin ke ASICs.

Milikilah konten Anda dan kendalikan identitas Anda

Web awalnya dirancang sebagai jaringan terdesentralisasi di mana siapa pun dapat mempublikasikan dan terhubung. Seiring waktu, platform perusahaan mengonsolidasikan kontrol, menciptakan taman bermain di mana pengguna adalah produk dan konten terkunci. Gerakan Indie Web bertujuan untuk memulihkan janji awal web: kepemilikan pribadi, kebebasan kreatif, dan koneksi yang autentik.

Ketersediaan, harga ritel dunia nyata di enam negara, dan perbandingan dengan Mac Studio.

NVIDIA DGX Spark adalah nyata, tersedia untuk dibeli 15 Oktober 2025, dan ditujukan untuk pengembang CUDA yang membutuhkan pekerjaan LLM lokal dengan tumpukan AI NVIDIA yang terintegrasi. Harga MSRP AS $3.999; harga ritel UK/DE/JP lebih tinggi karena pajak dan saluran. Harga publik AUD/KRW belum secara luas diposting.