Open WebUI: Interfaccia Self-Hosted per LLM

Alternativa self-hosted a ChatGPT per LLM locali

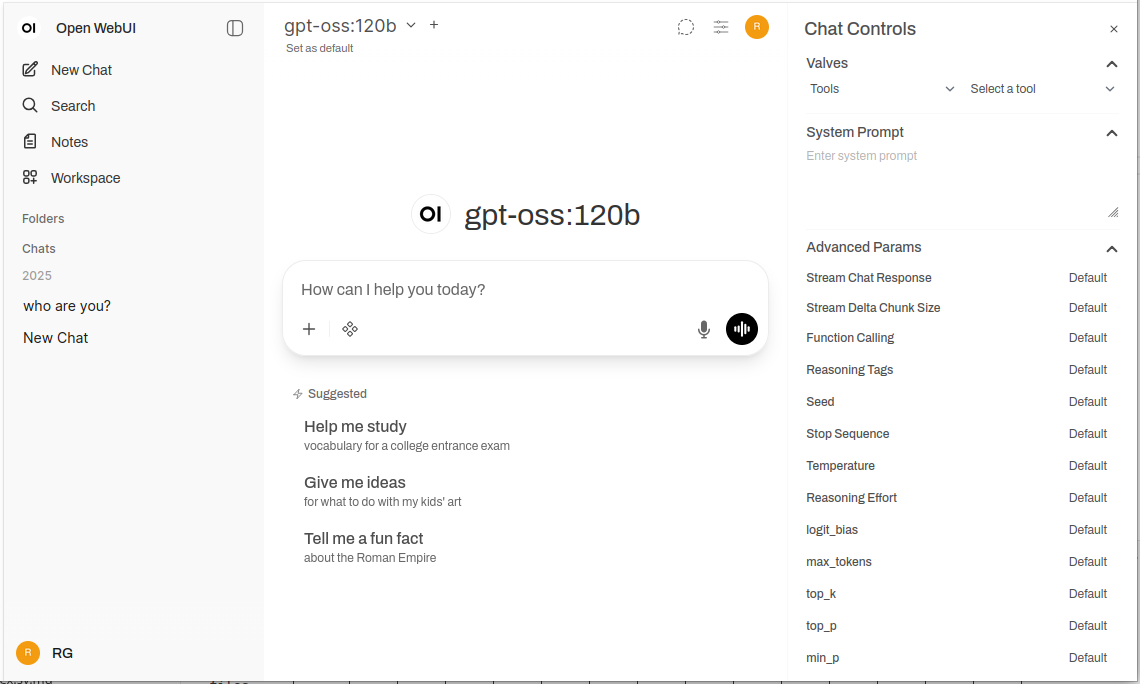

Open WebUI è una potente, estensibile e ricca di funzionalità interfaccia web autohostata per interagire con i modelli linguistici di grandi dimensioni.

Supporta Ollama e qualsiasi API compatibile con OpenAI, portando l’esperienza familiare di ChatGPT sulla tua infrastruttura con completa privacy, capacità offline e funzionalità a livello enterprise.

Cosa è Open WebUI?

Open WebUI è un’applicazione web open source autohostata che fornisce un’interfaccia moderna per interagire con i modelli linguistici di grandi dimensioni. A differenza dei servizi cloud basati sull’AI, Open WebUI funziona interamente sulla tua infrastruttura, dandoti il completo controllo sui tuoi dati, conversazioni e selezione dei modelli.

Sebbene Open WebUI venga comunemente utilizzato con Ollama (e talvolta chiamato informalemente “Ollama WebUI”), è in realtà una piattaforma indipendente dal backend. Può connettersi all’API di Ollama per l’esecuzione locale dei modelli, ma supporta anche qualsiasi endpoint compatibile con OpenAI, incluso vLLM, LocalAI, LM Studio, Text Generation WebUI e perfino fornitori cloud. Questa flessibilità rende Open WebUI una soluzione completa che supporta diversi backends, RAG (Retrieval-Augmented Generation) per conversazioni su documenti, autenticazione multi-utente, capacità vocali e opzioni di personalizzazione estese. Che tu stia eseguendo i modelli su un laptop, un server domestico o un cluster Kubernetes, Open WebUI si adatta alle tue esigenze.

Perché scegliere Open WebUI?

Privacy Prima di tutto: Tutti i dati rimangono sulla tua infrastruttura — nessuna conversazione, documento o prompt lascia la tua rete a meno che non configurare esplicitamente API esterne.

Capace di funzionare offline: Ideale per ambienti isolati, reti ristrette o situazioni in cui l’accesso a Internet è instabile o vietato. Quando abbinato a modelli eseguiti localmente tramite Ollama o vLLM, si ottiene un’indipendenza totale dai servizi cloud.

Ricco di funzionalità: Nonostante sia autohostato, Open WebUI compete con offerte commerciali grazie al caricamento di documenti e RAG, alla ricerca semantica nella cronologia delle conversazioni, a modelli di prompt e condivisione, gestione dei modelli, input/output vocali, design responsive per dispositivi mobili e temi scuri/chiari.

Supporto multi-utente: Sistema di autenticazione integrato con controllo degli accessi basato sui ruoli (amministratore, utente, in attesa), dashboard di gestione degli utenti, isolamento delle conversazioni e promemoria e modelli condivisi tra i team.

Guida rapida all’installazione

Il modo più rapido per iniziare con Open WebUI è utilizzando Docker. Questa sezione copre le situazioni di deployment più comuni.

Installazione base (connettersi a Ollama esistente)

Se hai già Ollama in esecuzione sul tuo sistema, utilizza questo comando:

docker run -d \

-p 3000:8080 \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:main

Questo esegue Open WebUI sulla porta 3000, persistendo i dati in un volume Docker. Accedilo a http://localhost:3000.

Installazione completa (Open WebUI + Ollama)

Per un setup completo e tutto-in-uno con Ollama incluso:

docker run -d \

-p 3000:8080 \

--gpus all \

-v ollama:/root/.ollama \

-v open-webui:/app/backend/data \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:ollama

La flag --gpus all abilita l’accesso alle GPU per un’inferenza più veloce. Omettila se stai eseguendo solo CPU.

Configurazione con Docker Compose

Per deployment in produzione, Docker Compose offre una migliore manutenibilità:

version: '3.8'

services:

ollama:

image: ollama/ollama:latest

ports:

- "11434:11434"

volumes:

- ollama:/root/.ollama

deploy:

resources:

reservations:

devices:

- driver: nvidia

count: all

capabilities: [gpu]

open-webui:

image: ghcr.io/open-webui/open-webui:main

ports:

- "3000:8080"

environment:

- OLLAMA_BASE_URL=http://ollama:11434

volumes:

- open-webui:/app/backend/data

depends_on:

- ollama

restart: always

volumes:

ollama:

open-webui:

Esegui il deployment con docker-compose up -d.

Deployment su Kubernetes

Per deployment enterprise, Open WebUI fornisce i chart Helm:

helm repo add open-webui https://helm.openwebui.com/

helm repo update

helm install open-webui open-webui/open-webui \

--set ollama.enabled=true \

--set ingress.enabled=true \

--set ingress.host=chat.yourdomain.com

Questo crea un deployment pronto per la produzione con archiviazione persistente, controlli di salute e configurazione opzionale dell’ingresso.

Analisi approfondita delle funzionalità principali

RAG e conversazione su documenti

L’implementazione di RAG di Open WebUI ti permette di caricare documenti e far riferire al modello su di essi nelle conversazioni. Il sistema suddivide automaticamente i documenti, genera gli embedding, li archivia in un database vettoriale e recupera il contesto rilevante quando fai domande.

Formati supportati: PDF, DOCX, TXT, Markdown, CSV e molti altri tramite parser integrati.

Utilizzo: Clicca sul pulsante ‘+’ in una chat, seleziona ‘Carica file’, scegli i tuoi documenti e inizia a fare domande. Il modello citrà i passaggi rilevanti e i numeri di pagina nelle sue risposte.

Configurazione: Puoi regolare la dimensione del chunk, l’overlap, il modello di embedding e i parametri di recupero nelle impostazioni amministrative per un’ottimale prestazione con i tuoi tipi di documenti.

Autenticazione e gestione multi-utente

Open WebUI include un sistema completo di autenticazione adatto all’uso in team e organizzazioni:

- Autenticazione locale: Username/password con hashing sicuro delle password

- Integrazione OAuth/OIDC: Connessione a provider di identità esistenti (Google, GitHub, Keycloak, ecc.)

- LDAP/Active Directory: Integrazione con directory aziendali

- Accesso basato sui ruoli: Amministratore (controllo completo), Utente (accesso standard), In attesa (richiede approvazione)

Gli amministratori possono gestire gli utenti, monitorare l’uso, configurare l’accesso ai modelli per utente/gruppo e impostare politiche di conservazione delle conversazioni.

Input e output vocali

Il supporto integrato per l’interazione vocale rende Open WebUI accessibile e conveniente:

- Riconoscimento vocale: Utilizza Web Speech API o servizi STT configurati esternamente

- Sintesi vocale: Supporto per diversi motori TTS (basati su browser, Coqui TTS, ElevenLabs, ecc.)

- Supporto linguistico: Funziona con diversi linguaggi a seconda della tua configurazione TTS/STT

Strumenti per l’ingegneria dei prompt

Open WebUI fornisce strumenti robusti per la gestione dei prompt:

- Libreria dei prompt: Salva i prompt frequentemente utilizzati come modelli

- Variabili e placeholder: Crea prompt riutilizzabili con contenuti dinamici

- Condivisione dei prompt: Condividi prompt efficaci con il tuo team

- Versionamento dei prompt: Traccia modifiche e miglioramenti nel tempo

Gestione dei modelli

Facile passaggio e gestione dei modelli tramite l’interfaccia utente:

- Catalogo dei modelli: Esplora e scarica modelli direttamente dalla libreria Ollama

- Modelli personalizzati: Carica e configura modelli GGUF personalizzati

- Parametri del modello: Regola la temperatura, top-p, lunghezza del contesto e altri parametri di campionamento per conversazione

- Metadati del modello: Visualizza dettagli del modello, dimensioni, quantizzazione e capacità

Configurazione e personalizzazione

Variabili di ambiente

Opzioni di configurazione principali tramite variabili di ambiente:

# URL del backend (Ollama o qualsiasi altra API compatibile con OpenAI)

OLLAMA_BASE_URL=http://localhost:11434

# Abilita l'autenticazione

WEBUI_AUTH=true

# Ruolo utente predefinito (utente, amministratore, in attesa)

DEFAULT_USER_ROLE=pending

# Abilita l'iscrizione degli utenti

ENABLE_SIGNUP=true

# Email dell'amministratore (crea automaticamente un account amministratore)

WEBUI_ADMIN_EMAIL=admin@example.com

# Database (predefinito SQLite, o PostgreSQL per produzione)

DATABASE_URL=postgresql://user:pass@host:5432/openwebui

# Abilita RAG

ENABLE_RAG=true

# Modello di embedding per RAG

RAG_EMBEDDING_MODEL=sentence-transformers/all-MiniLM-L6-v2

Connessione a backends alternativi

Open WebUI funziona con qualsiasi API compatibile con OpenAI. Configura l’URL base in Impostazioni → Connessioni:

- vLLM:

http://localhost:8000/v1 - LocalAI:

http://localhost:8080 - LM Studio:

http://localhost:1234/v1 - Text Generation WebUI:

http://localhost:5000/v1 - OpenAI:

https://api.openai.com/v1(richiede chiave API) - Azure OpenAI: URL endpoint personalizzato

Configurazione del reverse proxy

Per deployment in produzione, esegui Open WebUI dietro un reverse proxy:

Esempio Nginx:

server {

listen 443 ssl http2;

server_name chat.yourdomain.com;

ssl_certificate /path/to/cert.pem;

ssl_certificate_key /path/to/key.pem;

location / {

proxy_pass http://localhost:3000;

proxy_set_header Host $host;

proxy_set_header X-Real-IP $remote_addr;

proxy_set_header X-Forwarded-For $proxy_add_x_forwarded_for;

proxy_set_header X-Forwarded-Proto $scheme;

# Supporto WebSocket

proxy_http_version 1.1;

proxy_set_header Upgrade $http_upgrade;

proxy_set_header Connection "upgrade";

}

}

Esempio Traefik (etichette Docker):

labels:

- "traefik.enable=true"

- "traefik.http.routers.openwebui.rule=Host(`chat.yourdomain.com`)"

- "traefik.http.routers.openwebui.entrypoints=websecure"

- "traefik.http.routers.openwebui.tls.certresolver=letsencrypt"

- "traefik.http.services.openwebui.loadbalancer.server.port=8080"

Ottimizzazione delle prestazioni

Regolazione del database

Per deployment multi-utente, passa da SQLite a PostgreSQL:

# Installa le dipendenze

pip install psycopg2-binary

# Configura l'URL del database

DATABASE_URL=postgresql://openwebui:password@postgres:5432/openwebui

PostgreSQL gestisce meglio gli utenti contemporanei e offre prestazioni di query migliorate per la ricerca di conversazioni e operazioni RAG.

Selezione del modello di embedding

Le prestazioni di RAG dipendono pesantemente dalla scelta del modello di embedding:

- Veloci/Risorse limitate:

all-MiniLM-L6-v2(384 dimensioni, ~80MB) - Equilibrio:

all-mpnet-base-v2(768 dimensioni, ~420MB) - Migliore qualità:

bge-large-en-v1.5(1024 dimensioni, ~1,3GB)

Configura in Impostazioni → RAG → Modello di embedding.

Strategie di caching

Abilita il caching delle conversazioni per ridurre le chiamate API ripetute:

- Caching dei modelli: Ollama memorizza automaticamente i modelli caricati in memoria

- Caching delle risposte: Open WebUI può memorizzare risposte identiche (configurabile)

- Caching degli embedding: Riutilizza gli embedding per documenti precedentemente elaborati

Linee guida per la sicurezza

Quando si distribuisce Open WebUI in produzione, segui queste linee guida per la sicurezza:

- Abilita l’autenticazione: Mai eseguire Open WebUI senza autenticazione su reti pubbliche

- Utilizza HTTPS: Sempre distribuisci dietro un reverse proxy con TLS/SSL

- Aggiornamenti regolari: Mantieni aggiornati Open WebUI e Ollama per le patch di sicurezza

- Limita l’accesso: Utilizza regole del firewall per limitare l’accesso alle reti attendibili

- Protezione delle chiavi API: Se si connette a API esterne, utilizza variabili di ambiente, mai codificare le chiavi

- Log di audit: Abilita e monitora i log di accesso per attività sospette

- Backup dei dati: Esegui regolarmente il backup del volume

/app/backend/data - Criptaggio del database: Abilita il criptaggio a riposo per PostgreSQL in produzione

- Limiti di velocità: Configura limiti di velocità per prevenire l’abuso

- Filtraggio del contenuto: Implementa politiche di contenuto appropriate per la tua organizzazione

Caso d’uso e applicazioni reali

Assistente personale per la conoscenza

Combina Open WebUI con modelli locali e RAG per creare una base di conoscenza privata. Carica le tue note, articoli di ricerca, documenti di progetto e documenti personali. Fai domande in modo conversazionale senza inviare dati ai servizi cloud — perfetto per ricercatori, studenti e lavoratori della conoscenza che valorizzano la privacy.

Collaborazione del team di sviluppo

Distribuisci Open WebUI per il tuo team di sviluppo con accesso condiviso a documentazione tecnica, specifiche API e conoscenza del codice. La funzione RAG permette agli sviluppatori di trovare rapidamente informazioni rilevanti su migliaia di pagine di documenti, mentre la cronologia delle conversazioni aiuta a tracciare le decisioni architettoniche e le discussioni tecniche.

Chatbot interno per aziende

Le organizzazioni possono distribuire Open WebUI dietro il loro firewall con integrazione SSO, fornendo agli impiegati un assistente AI che ha accesso a wiki interni, politiche e procedure. L’accesso basato sui ruoli garantisce che le informazioni sensibili rimangano segmentate correttamente, mentre i controlli amministrativi mantengono la governance e la conformità.

Educazione e formazione

Le istituzioni educative utilizzano Open WebUI per fornire agli studenti e al personale assistenza AI senza preoccupazioni di privacy. Carica materiali didattici, testi e appunti delle lezioni per domande contestuali. Il sistema multi-utente permette di tracciare l’utilizzo mantenendo i dati degli studenti privati.

Applicazioni sanitarie e legali

Negli settori regolamentati in cui la privacy dei dati è cruciale, Open WebUI consente flussi di lavoro assistiti dall’AI mantenendo la conformità a HIPAA o GDPR. I professionisti sanitari possono interrogare database farmaceutici e protocolli di trattamento, mentre i team legali possono cercare casi legali e contratti — tutto senza che i dati lascino l’infrastruttura controllata.

Ambienti isolati e offline

Gli uffici governativi, i centri di ricerca e le operazioni di sicurezza utilizzano Open WebUI in reti isolate. La completa capacità offline garantisce che l’assistenza AI rimanga disponibile anche senza connessione Internet, essenziale per ambienti classificati o ubicazioni remote.

Risoluzione dei problemi comuni

Problemi di connessione

Problema: Open WebUI non riesce a connettersi a Ollama

Soluzione: Verifica che Ollama stia funzionando (curl http://localhost:11434), controlla la variabile di ambiente OLLAMA_BASE_URL e assicurati che le regole del firewall permettano la connessione. Per le deployment Docker, utilizza i nomi dei servizi (http://ollama:11434) invece di localhost.

Problema: I modelli non appaiono nell’interfaccia utente

Soluzione: Conferma che i modelli siano installati (ollama list), aggiorna l’elenco dei modelli nelle impostazioni di Open WebUI e controlla il console del browser per errori API.

Problemi di caricamento documenti e RAG

Problema: Il caricamento dei documenti fallisce

Soluzione: Controlla i limiti di dimensione dei file nelle impostazioni, verifica il formato del file supportato, assicurati che vi sia spazio sufficiente nel volume dati e controlla i log del container per errori di analisi.

Problema: Le risposte RAG non fanno riferimento ai documenti caricati

Soluzione: Verifica che il modello di embedding sia scaricato e in esecuzione, controlla le impostazioni della dimensione del chunk (prova dimensioni più piccole per una granularità migliore), aumenta il numero di chunk recuperati nelle impostazioni RAG e assicurati che la domanda sia rilevante al contenuto dei documenti.

Problemi di prestazioni

Problema: Risposte lente

Soluzione: Abilita l’accelerazione GPU se disponibile, riduci la dimensione del modello o utilizza versioni quantizzate, aumenta OLLAMA_NUM_PARALLEL per le richieste parallele e alloca più RAM ai contenitori Docker.

Problema: Errori di memoria insufficiente

Soluzione: Utilizza modelli più piccoli (7B invece di 13B di parametri), riduci la lunghezza del contesto nei parametri del modello, limita gli utenti contemporanei o aggiungi più RAM/spazio di swap al sistema.

Autenticazione e accesso

Problema: Non è possibile accedere o creare un account amministratore

Soluzione: Imposta WEBUI_AUTH=true, configura WEBUI_ADMIN_EMAIL per creare automaticamente un amministratore, cancella i cookie e la cache del browser e controlla i log del container per errori del database.

Problema: Gli utenti non possono registrarsi

Soluzione: Verifica ENABLE_SIGNUP=true, controlla l’impostazione DEFAULT_USER_ROLE (usa user per l’approvazione automatica o pending per l’approvazione manuale) e assicurati che il database sia scrivibile.

Alternative a Open WebUI

Sebbene Open WebUI eccella nel fornire un’interfaccia autohostata con un’integrazione forte con Ollama, diverse alternative offrono approcci diversi allo stesso spazio problema. La tua scelta dipende da se hai bisogno di flessibilità multi-provider, gestione specializzata dei documenti, estrema semplicità o funzionalità enterprise.

LibreChat si distingue come soluzione più indipendente dal provider, offrendo supporto nativo per OpenAI, Anthropic, Azure OpenAI, Google Vertex AI, AWS Bedrock e Ollama in un’unica interfaccia. La sua architettura plugin e le funzionalità enterprise come multi-tenancy, controlli dettagliati degli accessi e quote di utilizzo lo rendono ideale per organizzazioni che devono supportare diversi fornitori AI o richiedono tracciabilità dettagliata. Il compromesso è la complessità — LibreChat richiede più sforzo di configurazione e risorse pesanti rispetto a Open WebUI, e il supporto per Ollama sembra secondario rispetto ai fornitori cloud. Se il tuo team utilizza Claude per scrivere, GPT-4 per il coding e modelli locali per il lavoro sensibile alla privacy, l’interfaccia unificata di LibreChat risplende.

Per flussi di lavoro intensi su documenti, AnythingLLM adotta un approccio basato sul knowledge base che va oltre il RAG di base. Il suo modello di workspace organizza documenti e conversazioni in ambienti isolati, mentre le avanzate funzionalità di recupero includono ricerca ibrida, rirango e tracciamento delle citazioni. I connettori dati estraggono contenuto da GitHub, Confluence e Google Drive, e le capacità agenti abilitano ragionamento multi-step e automazione dei workflow. Questo rende AnythingLLM eccellente per studi legali che gestiscono diverse basi di conoscenza clienti o team di supporto che lavorano con documenti estesi. L’interfaccia chat è meno raffinata rispetto a Open WebUI, ma se la tua principale esigenza è interrogare grandi raccolte di documenti, le sofisticate capacità di recupero giustificano la curva di apprendimento più ripida.

LobeChat privilegia l’esperienza utente rispetto alla profondità delle funzionalità, offrendo un’interfaccia moderna e mobile-friendly con capacità di progressive web app. Il suo design moderno, animazioni fluide e forte supporto vocale/multimodale lo rendono popolare tra designer e utenti non tecnici che desiderano un assistente AI che funziona senza problemi su dispositivi diversi. L’implementazione PWA fornisce un’esperienza simile a un’app mobile che Open WebUI non riesce a replicare. Tuttavia, le funzionalità enterprise sono limitate, l’ecosistema plugin è più piccolo e le capacità RAG sono inferiori rispetto a Open Web端 e AnythingLLM.

Per gli utenti che preferiscono applicazioni desktop, Jan.ai fornisce installatori cross-platform (Windows, macOS, Linux) con gestione locale dei modelli senza configurazione. Non è necessario installare Ollama separatamente o occuparsi di Docker — Jan include tutto in un’app nativa con supporto per il tray del sistema e download dei modelli con un clic. Questo “funziona subito” rende Jan ideale per fornire LLM locali a familiari o colleghi che non si sentono a loro agio con gli strumenti da riga di comando. I compromessi sono la mancanza di supporto multi-utente, poche funzionalità avanzate e mancanza di capacità di accesso remoto.

Chatbox occupa la nicchia leggera — un client cross-platform minimalista che supporta OpenAI, Claude, Gemini e API locali con un overhead di risorse molto basso. È perfetto per sviluppatori che devono testare rapidamente diversi fornitori API o utenti con hardware a risorse limitate. L’attrito di configurazione è minimo, ma alcune funzionalità sono sottoposte a abbonamento, non è completamente open source e il supporto RAG è limitato.

Esistono diversi UI minimali specifici per Ollama per gli utenti che desiderano “solo abbastanza” interfaccia: Hollama gestisce diversi server Ollama su macchine diverse, Ollama UI fornisce chat base e caricamento di PDF con un’implementazione estremamente facile, e Oterm offre un’interfaccia di terminali sorprendentemente capace per sessioni SSH e workflow tmux. Questi sacrificano funzionalità per semplicità e velocità.

Per organizzazioni che richiedono supporto da parte di un fornitore, opzioni commerciali come TypingMind Team, BionicGPT e Dust.tt offrono autohosting con supporto professionale, certificazioni di conformità e SLA. Scambiano la libertà open source per garantita disponibilità, audit di sicurezza e responsabilità — appropriato quando l’organizzazione necessita di contratti di supporto enterprise.

Scegliere con saggezza: Open WebUI colpisce il punto giusto per la maggior parte delle deployment autohostate su Ollama, bilanciando funzionalità complete con complessità gestibile. Scegli LibreChat quando la flessibilità multi-provider è cruciale, AnythingLLM per flussi di lavoro documentali sofisticati, LobeChat per utenti mobili-first o progettisti, Jan per utenti desktop non tecnici o opzioni commerciali quando è necessario supporto da parte di un fornitore. Per la maggior parte degli utenti tecnici che eseguono modelli locali, lo sviluppo attivo, la forte comunità e l’implementazione eccellente di RAG di Open WebUI lo rendono il punto di partenza raccomandato.

Sviluppi futuri e roadmap

Open WebUI continua a svilupparsi rapidamente con diverse funzionalità eccitanti in roadmap:

Miglior supporto multimodale: Gestione migliore di immagini, modelli visivi e conversazioni multimodali con modelli come LLaVA e Bakllava.

Funzionalità avanzate degli agenti: Chiamata a funzioni, utilizzo di strumenti e flussi di lavoro di ragionamento multi-step simili a AutoGPT.

Miglior app mobile: App native iOS e Android oltre all’implementazione corrente PWA per un’esperienza mobile migliorata.

Funzionalità RAG avanzate: RAG basato su grafi, chunking semantico, recupero multi-query e recupero documenti genitore per un contesto migliore.

Funzionalità collaborative: Conversazioni condivise, spazi di lavoro di team e collaborazione in tempo reale su prompt e documenti.

Integrazioni enterprise: Supporto SSO più profondo, provisioning SCIM, log di audit avanzati e reporting di conformità per settori regolamentati.

Il progetto mantiene la compatibilità all’indietro e la versioning semantico, rendendo gli aggiornamenti semplici. Il repository attivo su GitHub vede commit quotidiani e gestione reattiva degli issue.

Conclusione

Open WebUI è evoluto da un semplice frontend per Ollama in una piattaforma completa per interazioni autohostate con l’AI. La sua combinazione di privacy, funzionalità e facilità di deployment lo rende un’ottima scelta per individui, team e organizzazioni che desiderano sfruttare LLM locali senza sacrificare capacità.

Che tu sia uno sviluppatore che testa modelli, un’organizzazione che costruisce strumenti AI interni o un individuo che privilegia la privacy, Open WebUI fornisce la base per potenti flussi di lavoro AI autohostati. La comunità attiva, gli aggiornamenti regolari e l’architettura estensibile garantiscono che rimanga un’opzione leader nello spazio degli AI autohostati.

Inizia con l’installazione base Docker, sperimenta con RAG caricando alcuni documenti, prova diversi modelli dalla libreria Ollama e gradualmente esplora funzionalità avanzate mentre le tue esigenze crescono. La curva di apprendimento è dolce, ma il tetto è alto — Open WebUI si estende da un laptop personale a un cluster Kubernetes enterprise.

Per coloro che confrontano alternative, il design Ollama-first, l’insieme di funzionalità bilanciato e lo sviluppo attivo di Open WebUI lo rendono il punto di partenza raccomandato per la maggior parte delle deployment LLM autohostate. Puoi sempre migrare a soluzioni più specializzate se emergono esigenze specifiche, ma molti utenti trovano le capacità di Open WebUI sufficienti per il loro intero viaggio dall’esperimento alla produzione.

Link utili

Quando configuri l’ambiente Open WebUI, ti sarà utile comprendere l’ecosistema più ampio di hosting e opzioni di deployment per LLM locali. La guida completa Local LLM Hosting: Complete 2025 Guide - Ollama, vLLM, LocalAI, Jan, LM Studio & More confronta 12+ strumenti locali per LLM, tra cui Ollama, vLLM, LocalAI e altri, aiutandoti a scegliere il backend ottimale per il tuo deployment Open WebUI basandosi sulla maturità API, capacità di chiamata degli strumenti e benchmark di prestazioni.

Per deployment di produzione ad alte prestazioni in cui throughput e latenza sono critici, esplora la guida vLLM Quickstart: High-Performance LLM Serving, che copre l’installazione di vLLM con Docker, la compatibilità API OpenAI e l’ottimizzazione PagedAttention. Questo è particolarmente utile se Open WebUI serve diversi utenti contemporanei e le prestazioni di Ollama diventano un collo di bottiglia.

Comprendere come il tuo backend gestisce le richieste parallele è cruciale per la pianificazione della capacità. L’articolo How Ollama Handles Parallel Requests spiega la coda delle richieste di Ollama, la gestione della memoria GPU e il modello di esecuzione parallela, aiutandoti a configurare i limiti appropriati e le aspettative per gli scenari multi-utente del tuo deployment Open WebUI.

Risorse esterne

Per documentazione ufficiale e supporto comunitario, consulta queste risorse esterne: