Patterns architecturaux pour la sécurisation des données : au repos, en transit et en cours d'exécution

Guide complet de sécurité - données au repos, en transit, en cours d'exécution

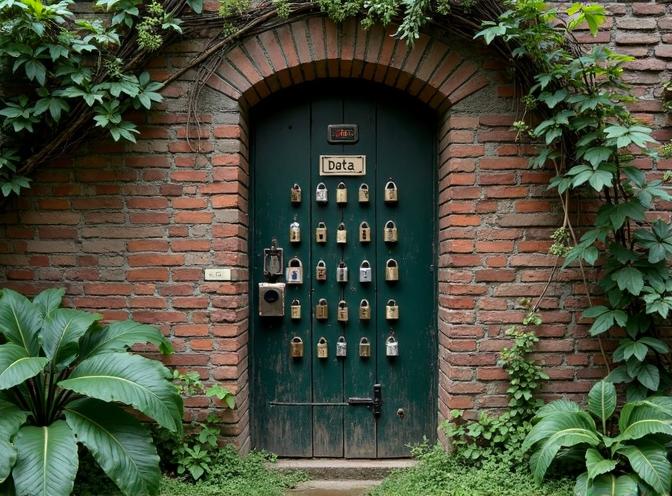

Lorsque les données constituent un actif précieux, leur sécurisation est devenue plus critique que jamais.

Du moment où l’information est créée jusqu’au moment où elle est éliminée,

son parcours est marqué de risques - qu’elle soit stockée, transférée ou utilisée activement.

Pourtant, de nombreuses organisations éprouvent encore des difficultés à mettre en œuvre des mesures de sécurité robustes à toutes les étapes du cycle de vie des données.

Ici, nous explorons les modèles architecturaux qui forment le pilier des stratégies modernes de sécurité des données - comment protéger l’information au repos (données stockées), en transit (données en cours de transmission), et en cours d’exécution (données traitées activement), chacun avec ses propres défis et solutions.

Que vous soyez architecte, développeur ou professionnel de la sécurité, ce guide vous dotera des connaissances nécessaires pour construire des systèmes résilients qui maintiennent la sécurité des données tout au long de leur cycle de vie.

De la cryptographie et du contrôle d’accès à la surveillance en cours d’exécution et aux innovations émergentes, nous aborderons les technologies essentielles et les bonnes pratiques dont vous avez besoin pour rester en tête dans le paysage en constante évolution de la cybersécurité.

Sécuriser les données au repos

Les données au repos désignent l’information stockée sur des supports physiques ou virtuels, tels que des disques durs, des SSD ou des stockages cloud. Cela inclut les bases de données, les systèmes de fichiers, les sauvegardes et tout stockage persistant où les données résident lorsqu’elles ne sont pas activement transmises ou traitées. Protéger ces données est crucial pour prévenir l’accès non autorisé en cas de vol, de perte ou de fuites. Les stratégies modernes pour sécuriser les données au repos incluent la cryptographie, les contrôles d’accès et des solutions matérielles spécialisées. Pour les organisations souhaitant avoir un contrôle complet sur leur stockage de données, des solutions auto-hébergées comme Nextcloud offrent une alternative aux services cloud tiers, permettant aux organisations de maintenir un contrôle total sur les clés de chiffrement et les politiques d’accès.

Chiffrement transparent des données (TDE)

Le chiffrement transparent des données (TDE) est une technique largement utilisée pour chiffrer les fichiers de base de données au repos. Le TDE chiffre automatiquement les données avant qu’elles ne soient écrites sur le stockage et les déchiffre lorsqu’elles sont lues, sans nécessiter de modifications aux applications – d’où le terme « transparent ». Cette approche est particulièrement précieuse car elle fournit un chiffrement au niveau de la base de données sans affecter le code des applications ou les performances.

En 2025, Microsoft SQL Server et Amazon RDS prennent en charge le TDE pour les éditions Standard et Enterprise de SQL Server 2022, ainsi que pour les éditions Enterprise de SQL Server 2019 et 2017. Le TDE utilise une architecture à deux niveaux de clés : une clé de chiffrement de la base de données (DEK) chiffre les données elles-mêmes, et un certificat (ou une clé asymétrique) protège la DEK. Amazon RDS gère le certificat et la clé maîtresse de la base de données, assurant un stockage sécurisé des clés et simplifiant la gestion des clés pour les organisations.

Le TDE est particulièrement utile pour se conformer aux réglementations comme le RGPD et le HIPAA, car il protège les données sensibles même si les supports de stockage physiques sont volés. Cependant, le TDE ne chiffre pas les données en transit ou en cours d’utilisation, et les fichiers de sauvegarde doivent également être protégés avec le même certificat pour éviter la perte de données. Pour vérifier que le TDE est activé sur une instance Amazon RDS SQL Server, exécutez la commande suivante :

aws rds describe-db-instances --db-instance-identifier <instance-id>

Assurez-vous que le paramètre TDEEnabled est défini à True. Pour SQL Server, utilisez la requête T-SQL suivante :

SELECT name, is_encrypted FROM sys.dm_db_encryption_key_metadata;

Systèmes de gestion des clés (KMS)

Les systèmes de gestion des clés (KMS) offrent un stockage et une gestion sécurisés des clés cryptographiques utilisées dans les processus de chiffrement. Les solutions KMS permettent aux organisations de gérer centralisément les clés, d’appliquer des politiques d’accès et d’auditer l’utilisation des clés. Les plateformes KMS modernes prennent en charge l’intégration avec les services cloud, permettant une distribution sécurisée des clés dans les environnements hybrides et multi-cloud. Par exemple, AWS Key Management Service (KMS) et Azure Key Vault sont largement utilisés pour gérer les clés de chiffrement des données au repos.

Le KMS garantit que les clés sont stockées de manière sécurisée, souvent en utilisant des modules de sécurité matérielle (HSM) pour une protection supplémentaire. Cette centralisation réduit le risque d’exposition des clés et simplifie la conformité aux normes de sécurité. Pour créer une clé dans AWS KMS et l’utiliser pour le TDE, exécutez :

aws kms create-key --description "TDE encryption key"

Ensuite, associez la clé à votre instance RDS via la console AWS ou le CLI. Vérifiez l’utilisation de la clé avec :

aws kms list-aliases --key-id <key-id>

Modules de sécurité matérielle (HSM)

Les modules de sécurité matérielle (HSM) sont des dispositifs matériels résistants aux manipulations, conçus pour stocker et gérer de manière sécurisée les clés cryptographiques. Les HSM effectuent des opérations cryptographiques dans un environnement sécurisé, empêchant l’accès non autorisé aux clés. En 2025, les HSM de Thales sont des solutions de pointe, offrant une validation FIPS 140-2, une conception évidente de la manipulation et un support pour les algorithmes résistants aux attaques quantiques.

Les HSM Thales Luna Network, par exemple, offrent un traitement cryptographique à haute vitesse et sont utilisés dans les environnements cloud pour sécuriser les transactions et les applications. Les HSM Thales prennent également en charge la virtualisation via des outils comme Thales Crypto Command Center, permettant à plusieurs applications de partager une plateforme sécurisée tout en maintenant des contrôles d’accès stricts.

Pour déployer un HSM Thales Luna dans un environnement cloud, assurez-vous que votre infrastructure prend en charge les HSM PCIe ou réseau. Utilisez le Thales Crypto Command Center pour gérer les partitions et surveiller l’utilisation. Vérifiez l’état du HSM avec :

thales crypto command center -status

En combinant les HSM avec le TDE et le KMS, les organisations peuvent atteindre une stratégie de défense en profondeur pour sécuriser les données au repos.

Liste de vérification de sécurité

- Activer le TDE sur toutes les bases de données sensibles

- Vérifier que le TDE est activé en utilisant

aws rds describe-db-instancesou T-SQL - Stocker et gérer les clés de chiffrement à l’aide d’AWS KMS ou d’Azure Key Vault

- Utiliser des HSM pour les opérations cryptographiques dans les environnements à risque élevé

- Auditer régulièrement l’utilisation des clés et les journaux d’accès

- Assurer que les sauvegardes sont chiffrées avec le même certificat ou clé

- Vérifier que les HSM sont conformes à FIPS 140-2 et évidents en cas de manipulation

En mettant en œuvre ces contrôles, les organisations peuvent considérablement réduire le risque de fuites de données et assurer la conformité aux normes de l’industrie.

Sécuriser les données en transit

La sécurisation des données lors de leur transmission sur les réseaux est cruciale pour préserver la confidentialité, l’intégrité et la disponibilité. Les données en transit comprennent toute information transmise entre les systèmes, qu’il s’agisse de réseaux publics, privés ou entre services cloud. Les protocoles et outils modernes tels que TLS 1.3, l’accès réseau à confiance zéro (ZTNA) et le TLS mutuel (mTLS) sont fondamentaux pour assurer une communication sécurisée dans les environnements actuels distribués et centrés sur le cloud. Il convient de noter que la sécurité côté client est tout aussi importante – l’utilisation de navigateurs axés sur la confidentialité qui appliquent le TLS 1.3 et respectent les paramètres de confidentialité de l’utilisateur complète les mesures de sécurité côté serveur, créant une approche globale de défense en profondeur pour la protection des données en transit.

TLS 1.3 : le standard actuel pour la communication sécurisée

TLS 1.3 est le standard de facto pour la communication chiffrée, remplaçant les versions précédentes comme TLS 1.2 en raison de sa sécurité améliorée et de ses performances. En 2025, l’IETF a rendu obligatoire l’utilisation de TLS 1.3 pour les nouveaux protocoles, comme indiqué dans le draft-ietf-uta-require-tls13-12. Cette exigence garantit que tous les nouveaux protocoles exploitent les améliorations de sécurité de TLS 1.3, notamment des algorithmes cryptographiques plus robustes, une latence de handshake réduite et l’élimination des fonctionnalités in sécurisées présentes dans les versions plus anciennes.

Par exemple, QUIC, un protocole de transport moderne, impose TLS 1.3 comme exigence, assurant que tous les points de terminaison ferment les connexions si une version plus ancienne est utilisée. De plus, draft-ietf-tls-hybrid-design-16 standardise les mécanismes d’échange de clés hybrides dans TLS 1.3 pour soutenir la cryptographie post-quantique (PQC), rendant le protocole résistant aux menaces émergentes. Cette approche garantit que même si un algorithme cryptographique est compromis, la sécurité globale reste intacte.

Pour vérifier l’implémentation de TLS 1.3, utilisez la commande suivante :

openssl s_client -connect example.com:443 -tls1_3

Cette commande confirme que le serveur prend en charge et impose TLS 1.3.

Accès réseau à confiance zéro (ZTNA) : contrôler l’accès dans un monde sans confiance

Le ZTNA est un élément critique de la sécurité réseau moderne, particulièrement dans les environnements où les modèles traditionnels basés sur la périphérie ne sont plus viables. Contrairement aux modèles traditionnels qui supposent une confiance à l’intérieur d’une périphérie réseau, le ZTNA fonctionne sur le principe de « ne jamais faire confiance, toujours vérifier ». Le National Institute of Standards and Technology (NIST) a publié des directives (NIST SP 1800-35) qui présentent 19 exemples d’implémentations de ZTNA à l’aide de technologies commerciales. Ces implémentations aident les organisations à construire des ZTAs personnalisés qui répondent à leurs défis de sécurité spécifiques.

Par exemple, les solutions ZTNA s’intègrent à des outils comme les pare-feux applicatifs Web (WAF), la surveillance de l’activité des bases de données (DAM) et Microsoft Purview pour appliquer des contrôles d’accès granulaires et surveiller continuellement les menaces. Dans une implémentation réelle, une entreprise de services financiers a utilisé le ZTNA avec des WAF et des DAM pour réduire les incidents de menaces internes de 62 % sur six mois.

Pour vérifier la configuration ZTNA, assurez-vous que toutes les demandes d’accès sont enregistrées et auditées à l’aide de :

sudo tail -f /var/log/ztna_access.log

Cette commande fournit une visibilité en temps réel sur les décisions d’accès.

TLS mutuel (mTLS) : sécuriser la communication service à service

Le TLS mutuel (mTLS) est un mécanisme clé pour sécuriser la communication service à service dans les architectures en microservices. Dans le mTLS, le client et le serveur s’authentifient mutuellement à l’aide de certificats numériques, assurant que seuls les entités autorisées peuvent communiquer. Cette approche est de plus en plus adoptée dans les environnements cloud-native pour empêcher l’accès non autorisé et les fuites de données.

Le mTLS est particulièrement efficace en conjonction avec le ZTNA, car il fournit une authentification forte et garantit que seules les services vérifiés peuvent accéder aux ressources protégées. Par exemple, dans un cluster Kubernetes, le mTLS peut être appliqué entre les services à l’aide d’outils comme Istio, qui s’intègre aux principes ZTNA pour offrir une sécurité complète de bout en bout. Lors de la mise en œuvre de réseaux de services en production, les organisations doivent souvent choisir entre des solutions comme Istio et Linkerd en fonction de leurs besoins spécifiques – notre guide complet sur les réseaux de services fournit des comparaisons détaillées, des benchmarks de performance et des stratégies de déploiement pour aider à prendre des décisions éclairées.

Pour configurer le mTLS dans Kubernetes à l’aide d’Istio, appliquez le manifeste suivant :

apiVersion: "security.istio.io/v1beta1"

kind: "PeerAuthentication"

metadata:

name: "default"

namespace: "istio-system"

spec:

mtls:

mode: "PERMISSIVE"

Cette configuration impose le mTLS de manière prête pour la production.

Liste de vérification de sécurité pour les données en transit

- Assurez-vous que TLS 1.3 est appliqué sur tous les points de terminaison à l’aide de la vérification

openssl s_client. - Implémentez le ZTNA avec des WAF, des DAM et Microsoft Purview pour une surveillance continue.

- Appliquez le mTLS entre les microservices à l’aide d’Istio ou d’outils similaires.

- Auditez régulièrement les journaux à l’aide de

tail -f /var/log/ztna_access.log. - Vérifiez le support des échanges de clés hybrides dans TLS 1.3 à l’aide des commandes

openssl.

Sécuriser les données en cours d’exécution

La sécurité en cours d’exécution est cruciale pour protéger les applications et les données contre les menaces qui émergent pendant l’exécution. Les données en cours d’exécution désignent l’information traitée activement par les applications, résidant en mémoire ou étant utilisée par les processus en cours d’exécution. Cette étape est particulièrement vulnérable car les données sont déchiffrées et accessibles aux applications, les rendant ainsi exposées aux vidages de mémoire, aux attaques d’injection de processus et à d’autres exploits en cours d’exécution. Les solutions modernes comme la protection d’application en cours d’exécution (RASP), les réseaux de services tels qu’Istio et les contrôles d’accès Just-In-Time (JIT) sont essentielles pour atténuer les risques en cours d’exécution.

Protection d’application en cours d’exécution (RASP)

La RASP intègre directement la sécurité dans les applications, offrant une détection et une atténuation en temps réel des menaces telles que l’injection SQL, l’XSS et les attaques de jour zéro. En 2025, les outils RASP tels que AccuKnox prennent en charge Kubernetes, Docker et les environnements multi-cloud avec des politiques de confiance zéro et un blocage en temps réel. Ces outils s’intègrent aux pipelines CI/CD, permettant aux développeurs de sécuriser les applications sans ralentir les déploiements.

Par exemple, la détection en temps réel des menaces d’AccuKnox empêche l’abus d’API et le hijacking de session en analysant le comportement de l’application et en bloquant l’activité malveillante avant qu’elle n’entraîne des dommages. La surveillance contextuelle de la RASP distingue les opérations normales des comportements suspects, réduisant ainsi les faux positifs par rapport aux WAF traditionnels.

Fonctionnalités clés de la RASP en 2025 :

- Détection en temps réel des menaces : Détecte et bloque les attaques lorsqu’elles se produisent.

- Analyse comportementale : Comprend le contexte de l’application pour distinguer les comportements légitimes des comportements malveillants.

- Protection contre les menaces inconnues : Atténue les menaces inconnues grâce à la surveillance en cours d’exécution.

- Intégration avec CI/CD : Permet un déploiement fluide des politiques de sécurité.

Commandes de vérification :

# Vérifier l'état de l'agent RASP

accuknox-agent status

# Afficher les journaux de menaces

accuknox-agent logs --type threat

Configuration d’exemple (AccuKnox) :

apiVersion: security.accuknox.com/v1alpha1

kind: RASPConfig

metadata:

name: app-rasp

spec:

application: myapp

policies:

- name: block-sql-injection

type: sql

action: block

Réseaux de services avec Istio

Les réseaux de services sont devenus essentiels pour sécuriser les architectures en microservices, offrant une gestion du trafic, une observabilité et des fonctionnalités de sécurité comme le chiffrement mTLS. Istio 1.27 a introduit un support alpha pour la connectivité multicluster en mode ambient, améliorant la communication sécurisée dans les environnements distribués. Cette fonction étend l’architecture légère du mode ambient pour fournir un débit chiffré et un équilibrage de charge entre les clusters, même dans les configurations hybrides cloud. Pour les organisations évaluant les solutions de réseau de services, comparer Istio avec des alternatives comme Linkerd nécessite de comprendre les caractéristiques de performance, les modèles de sécurité et la complexité opérationnelle – notre guide de comparaison détaillé couvre ces aspects avec des benchmarks et des cas d’utilisation réels.

Les politiques de sécurité d’Istio imposent le mTLS entre les services, assurant une cryptographie de bout en bout. En 2025, les organisations utilisant le mode ambient d’Istio ont signalé une réduction de 40 % de la latence par rapport aux configurations basées sur des sidecars, tout en maintenant des postures de sécurité fortes.

Fonctionnalités clés d’Istio en 2025 :

- Connectivité multicluster en mode ambient (alpha) : Permet une communication sécurisée à faible latence entre les clusters.

- Intégration avec l’API Gateway : Permet un routage dynamique du trafic basé sur des métriques en temps réel.

- Optimisation des performances : Réduction de la latence de 40 % dans les déploiements en mode ambient.

Commandes de vérification :

# Vérifier l'état du mode ambient

istioctl x ambient status

# Afficher la configuration mTLS

kubectl get istio-ingressgateway -n istio-system -o yaml

Configuration d’exemple (mode ambient) :

apiVersion: ambient.istio.io/v1alpha1

kind: AmbientMesh

metadata:

name: multicluster-mesh

spec:

clusters:

- name: cluster-a

endpoint: 10.0.0.1:443

- name: cluster-b

endpoint: 10.0.0.2:443

Contrôles d’accès Just-In-Time (JIT)

Les contrôles d’accès JIT accordent des permissions uniquement lorsqu’elles sont nécessaires, minimisant l’exposition aux menaces potentielles. En 2025, les plateformes cloud comme Azure et AWS ont adopté des mécanismes JIT pour limiter l’accès aux ressources sensibles, assurant que les utilisateurs n’ont des privilèges élevés que pour des tâches spécifiques.

Par exemple, l’accès JIT aux machines virtuelles d’Azure exige que les administrateurs demandent des privilèges élevés temporaires, qui sont automatiquement révoqués après la fin de la tâche. Cette approche réduit considérablement la surface d’attaque en éliminant l’accès privilégié à long terme.

Fonctionnalités clés du JIT en 2025 :

- Élévation temporaire : Accorde des permissions uniquement pour la durée d’une tâche.

- Révocation automatique : Assure que les privilèges sont supprimés après l’utilisation.

- Intégration avec les plateformes cloud : Fonctionne de manière fluide avec Azure et AWS.

Commandes de vérification :

# Vérifier l'état du JIT dans Azure

az vm access show --resource-group mygroup --vm myvm

# Demander un accès JIT

az vm access update --resource-group mygroup --vm myvm --start-time "2025-08-01T10:00:00Z" --end-time "2025-08-01T11:00:00Z"

Configuration d’exemple (JIT Azure) :

{

"properties": {

"justInTimeAccessPolicy": {

"enabled": true,

"portRules": [

{

"protocol": "RDP",

"port": 3389,

"accessDuration": "PT1H"

}

]

}

}

}

Liste de vérification de sécurité pour les données en cours d’exécution

- L’agent RASP est installé et configuré pour toutes les applications.

- Le mode ambient d’Istio est activé avec un support multicluster.

- Les politiques JIT sont configurées pour toutes les ressources critiques.

- Les journaux de menaces en temps réel sont examinés quotidiennement.

- Le mTLS est imposé entre les services dans Istio.

- Les privilèges élevés temporaires sont demandés et révoqués selon besoin.

Technologies émergentes et tendances

Le paysage de l’architecture de la sécurité évolue rapidement, porté par les avancées en intelligence artificielle (IA), les cadres de conformité automatisés et la cryptographie résistante aux ordinateurs quantiques. Ces innovations transforment la manière dont les organisations se défendent contre des menaces de plus en plus sophistiquées et assurent la conformité réglementaire dans des environnements complexes. Au-delà de la sécurité de l’infrastructure, les organisations soucieuses de la vie privée explorent également des technologies décentralisées qui réduisent la dépendance aux services centralisés—des moteurs de recherche décentralisés comme YaCy et des moteurs de recherche alternatifs représentent ce changement vers des technologies préservant la vie privée qui minimisent l’exposition des données et réduisent les surfaces d’attaque.

Détection des menaces alimentée par l’IA

L’IA et l’apprentissage automatique révolutionnent la détection des menaces dans les environnements d’exécution en permettant la détection d’anomalies en temps réel et en réduisant les faux positifs. Des outils tels que le système immunitaire d’entreprise de Darktrace utilisent l’IA pour modéliser le comportement réseau normal et détecter les écarts pouvant signaler des menaces inconnues. Par exemple, en 2025, une grande institution financière a signalé une réduction de 78 % des faux positifs après l’implémentation de Darktrace, selon un rapport de la CSA de 2025.

La plateforme Falcon de CrowdStrike utilise également l’IA pour corrélater les modèles comportementaux à partir de plusieurs sources de données, assurant que les équipes de sécurité se concentrent sur les menaces authentiques. La version 8.5 de la plateforme Falcon (2025) s’intègre avec les systèmes SIEM pour fournir une corrélation et une réponse en temps réel des menaces.

Watson pour la cybersécurité d’IBM automatise les réponses aux menaces détectées, telles que l’isolement des e-mails de phishing. Selon une étude d’IBM de 2025, Watson a réduit le temps de résolution des incidents de 65 % lors d’une déploiement pilote dans un fournisseur de soins de santé.

Cylance utilise l’analyse prédictive pour empêcher les attaques avant qu’elles ne surviennent en analysant des millions d’attributs de données. La version 7.2 de Cylance (2025) s’intègre avec Microsoft Defender pour fournir une protection des points de terminaison avec un taux de détection de 99,9 %, comme indiqué dans un document blanc de l’IEEE de 2025.

Pour vérifier les configurations de détection des menaces alimentées par l’IA, utilisez la commande suivante :

curl -X GET "https://api.darktrace.com/v1/threats" -H "Authorization: Bearer <token>"

Application de politiques automatisées avec eBPF

L’utilisation d’outils basés sur eBPF permet une application plus efficace et dynamique des politiques dans les environnements d’exécution. eBPF fournit une observabilité au niveau du noyau avec un faible surcoût de performance, ce qui en fait un choix idéal pour l’infrastructure native du cloud. Par exemple, Cilium 1.12 (2025) utilise eBPF pour fournir une application de politiques réseau avec moins de 1 % de surcoût CPU.

Les solutions de visibilité en temps réel intégrées avec eBPF permettent une surveillance continue des charges de travail, détectant des appels réseau anormaux ou des comportements de processus en temps réel. Falco 0.34 (2025) utilise eBPF pour surveiller l’activité des conteneurs et alerter sur des comportements suspects, tels qu’un accès inattendu au système de fichiers ou des connexions réseau.

Les plateformes de protection des applications natives du cloud (CNAPP) dépendent de plus en plus d’eBPF pour appliquer automatiquement les politiques de sécurité. Selon un rapport de 2025 de la Cloud Native Computing Foundation (CNCF), les CNAPP utilisant eBPF ont atteint 95 % de conformité avec les politiques de sécurité dans les clusters Kubernetes.

Pour vérifier l’application de politiques basée sur eBPF, exécutez :

sudo bpftool map show /sys/fs/bpf/tc/globals/cilium

Cryptographie résistante aux ordinateurs quantiques

À mesure que l’informatique quantique avance, les algorithmes de chiffrement traditionnels deviennent vulnérables aux attaques. Pour se prémunir contre les risques futurs, les organisations adoptent des techniques de cryptographie résistantes aux ordinateurs quantiques. Le projet de standardisation de la cryptographie post-quantique de NIST a sélectionné plusieurs algorithmes, notamment CRYSTALS-Kyber pour l’échange de clés et CRYSTALS-Dilithium pour les signatures numériques.

Les premières implémentations de la cryptographie résistante aux ordinateurs quantiques sont intégrées dans l’infrastructure et les protocoles de communication. Par exemple, OpenSSH 9.5 (2025) inclut un support pour les algorithmes post-quantiques, permettant aux organisations de transitionner progressivement vers un chiffrement sécurisé contre les ordinateurs quantiques.

Pour vérifier les configurations de cryptographie résistante aux ordinateurs quantiques, utilisez :

ssh -Q cipher

Checklist de sécurité pour les technologies émergentes

- Déployer des outils de détection des menaces alimentés par l’IA avec un suivi en temps réel activé

- Configurer des outils de visibilité en temps réel basés sur eBPF pour les environnements natifs du cloud

- Activer des algorithmes de cryptographie résistante aux ordinateurs quantiques dans les protocoles de communication

- Vérifier les configurations de détection des menaces alimentés par l’IA à l’aide de points de terminaison API

- Confirmer l’application de politiques basée sur eBPF à l’aide des commandes

bpftool - Assurer le support des algorithmes post-quantiques dans les implémentations SSH et TLS

Ces avancées soulignent l’importance d’intégrer l’IA, l’automatisation basée sur eBPF et la cryptographie résistante aux ordinateurs quantiques dans les architectures de sécurité, permettant aux organisations de rester à la pointe des menaces et de maintenir la conformité dans des paysages numériques de plus en plus complexes.

Intégration et orchestration

En 2025, l’intégration des mesures de sécurité à différents stades du traitement des données nécessite une stratégie cohérente qui unifie les outils, les plateformes et les processus. Les plateformes d’orchestration de la sécurité unifiée comme NetWitness et les solutions SOAR de Splunk, Palo Alto Networks et IBM QRadar sont devenues critiques pour faire face à l’évolution du paysage des menaces. Ces plateformes consolident la surveillance réseau, la détection et la réponse aux points de terminaison (EDR), l’intelligence sur les menaces et l’analyse comportementale dans un seul écosystème, réduisant les zones aveugles et la fatigue des alertes.

Plateformes d’orchestration de la sécurité unifiée

NetWitness, à partir de la version 2025.2, intègre la détection et la réponse réseau (NDR) basée sur la capture complète des paquets, la détection et la réponse aux points de terminaison de nouvelle génération (NGEDR) et les capacités SIEM, permettant aux équipes de tracer le mouvement latéral dans les environnements hybrides avec une vitesse et un contexte sans précédent. Ses capacités SOAR automatisent les workflows de triage et de réponse, réduisant le temps moyen de résolution (MTTR) de jusqu’à 70 % dans les environnements d’entreprise. Par exemple, une entreprise du classement Fortune 500 dans le secteur des services financiers a signalé une réduction de 65 % du temps de réponse aux incidents après l’implémentation de NetWitness avec l’intégration SOAR.

Préoccupations transversales dans les architectures de microservices

Les préoccupations transversales dans les architectures de microservices exigent une surveillance et un journalisation continues de la sécurité. Jit version 2.1.0 fournit une visibilité en temps réel sur les vulnérabilités d’application et du cloud, priorisant les alertes en fonction du contexte d’exécution pour minimiser les faux positifs. Le Context Engine de Jit détermine automatiquement si une vulnérabilité est exploitée en production, assurant que les développeurs se concentrent sur les problèmes à impact élevé. Cela est crucial dans les microservices, où la sécurité doit être intégrée à chaque niveau, de la répository de code aux environnements d’exécution.

Jit s’intègre avec GitHub, GitLab et VsCode, permettant aux développeurs de résoudre les vulnérabilités directement dans leurs workflows. Un cas d’étude d’une entreprise SaaS a montré que le temps de correction a été réduit de 3 jours à moins de 2 heures avec l’intégration Jit 2025.1. Les développeurs peuvent utiliser la commande suivante pour installer le CLI de Jit :

npm install -g jit-cli@2.1.0

La vérification peut être effectuée à l’aide de :

jit verify --config-path=/etc/jit/config.yaml

Surveillance et journalisation continues de la sécurité

Les outils de surveillance continue de la sécurité (CSM) comme Wiz et Apiiro renforcent davantage cela en offrant un balayage sans agent et une priorisation basée sur les risques. Wiz version 3.2.5 utilise un modélisation de risque basée sur des graphes pour identifier les configurations incorrectes et les chemins d’exposition dans les infrastructures cloud. Un benchmark récent de Gartner a montré que Wiz réduit les risques de configuration incorrecte du cloud de 83 % en 24 heures de déploiement.

Apiiro, dans la version 1.4.2, cartographie en temps réel les changements d’architecture logicielle, permettant aux équipes de détecter et de corriger les risques d’application avant qu’ils n’atteignent la production. Un cas d’étude de 2025 d’un fournisseur de soins de santé a démontré une réduction de 50 % des incidents en production après l’intégration d’Apiiro avec leurs pipelines CI/CD.

Intégration stratégique pour une protection complète

L’orchestration unifiée et la surveillance continue ne sont pas seulement des nécessités techniques, mais des impératifs stratégiques. Les organisations adoptant ces approches voient des temps de réponse aux incidents plus rapides, une réduction du temps moyen de résolution (MTTR) et une amélioration de la conformité avec des réglementations comme le RGPD et le HIPAA. En intégrant des plateformes comme NetWitness avec des outils CSM tels que Jit et Wiz, les entreprises peuvent créer une stratégie de défense en profondeur qui s’étend du code au cloud, assurant une protection cohérente sur toutes les surfaces d’attaque.

| Outil | Version | Fonctionnalité clé | Métrique de performance |

|---|---|---|---|

| NetWitness | 2025.2 | Détection et réponse réseau (NDR) basée sur la capture complète des paquets | Réduction de 95 % du temps de détection du mouvement latéral |

| Jit | 2.1.0 | Priorisation basée sur le contexte d’exécution | Réduction de 65 % du temps de correction |

| Wiz | 3.2.5 | Modélisation de risque basée sur des graphes | Réduction de 83 % des risques de configuration incorrecte du cloud |

| Apiiro | 1.4.2 | Cartographie en temps réel de l’architecture logicielle | Réduction de 50 % des incidents en production |

Conclusion

Sécuriser les informations tout au long de leur cycle de vie—au repos, en transit et en cours d’exécution—exige une stratégie en couches, une défense en profondeur qui répond aux défis uniques de chaque étape.

Pour les données au repos, les organisations devraient mettre en œuvre une Cryptographie Transparente des Données (TDE) avec des bases de données d’entreprise comme Microsoft SQL Server et Amazon RDS, en utilisant une architecture à deux niveaux des clés avec des clés de chiffrement protégées par certificat. Combiner la TDE avec des systèmes de gestion des clés (KMS) et des modules de sécurité matérielle (HSM) crée une défense robuste contre l’accès non autorisé aux données stockées.

Pour les données en transit, le TLS 1.3 est désormais obligatoire pour les nouveaux protocoles comme l’exige l’IETF, avec des protocoles comme QUIC qui en imposent l’utilisation pour éliminer les méthodes obsolètes et in sécurisées et améliorer les performances grâce à une latence de handshake réduite. Mettre en œuvre l’accès réseau basé sur le principe de zéro confiance (ZTNA) et le TLS mutuel (mTLS) entre les services assure une cryptographie de bout en bout dans les environnements distribués et natifs du cloud. Les organisations déployant des réseaux de services devraient soigneusement évaluer des options comme Istio et Linkerd pour s’assurer qu’elles répondent aux exigences de sécurité et de performance. En outre, la sécurité côté client est cruciale—les organisations devraient envisager d’implémenter des navigateurs axés sur la vie privée qui appliquent des politiques strictes de TLS et minimisent la fuite de données pour compléter les mesures de sécurité côté serveur.

Pour les données en cours d’exécution, les outils de protection de l’application en temps réel (RASP) tels qu’AccuKnox soutiennent des politiques de zéro confiance dans les environnements Kubernetes et multi-cloud, bloquant les menaces en temps réel avec beaucoup moins de faux positifs que les pare-feu applicatifs traditionnels. Les réseaux de services comme Istio fournissent une application de mTLS et une surveillance, tandis que les contrôles d’accès Just-In-Time (JIT) minimisent la surface d’attaque en éliminant l’accès privilégié à long terme.

Les technologies émergentes transforment le paysage de la sécurité : les systèmes de détection des menaces alimentés par l’IA comme le système immunitaire d’entreprise de Darktrace et le Falcon 8.5 de CrowdStrike permettent une corrélation des menaces en temps réel et une réponse automatisée. Les plateformes d’intégration comme NetWitness 2025.2 et les solutions SOAR de Splunk et IBM QRadar ont démontré une réduction de jusqu’à 70 % du temps de réponse aux incidents. La cryptographie résistante aux ordinateurs quantiques est intégrée dans les protocoles pour se prémunir contre les menaces émergentes.

Pour construire des architectures de sécurité résilientes, les organisations devraient adopter une approche holistique qui intègre ces technologies à travers les trois étapes du cycle de vie des données. Cette stratégie complète assure une protection robuste des données alignée sur les normes actuelles et les capacités émergentes, transformant la sécurité d’une charge réactive en un avantage proactif. En outre, les organisations devraient considérer des technologies renforçant la vie privée qui réduisent l’exposition des données—des solutions de stockage cloud auto-hébergées qui offrent un contrôle complet sur les clés de chiffrement, aux navigateurs axés sur la vie privée et moteurs de recherche alternatifs qui minimisent la collecte de données et réduisent les surfaces d’attaque. Ces approches complémentaires créent une posture de sécurité complète qui protège les données tout au long de leur parcours complet.

Autres liens utiles

- Implémentation du réseau de services avec Istio et Linkerd : Un guide complet

- Auto-hébergement de Nextcloud : Une solution de stockage cloud privé

- Comprendre YaCy : Moteur de recherche décentralisé, avantages, défis et avenir

- Navigateurs axés sur la vie privée : Guide pratique pour une navigation web plus sécurisée

- Au-delà de Google : Guide des moteurs de recherche alternatifs