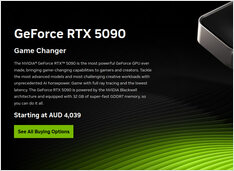

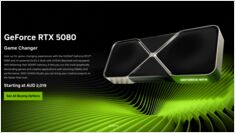

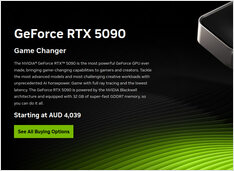

Prezzi dei GPU e della RAM in aumento in Australia: RTX 5090 +15%, RAM +38% - Gennaio 2026

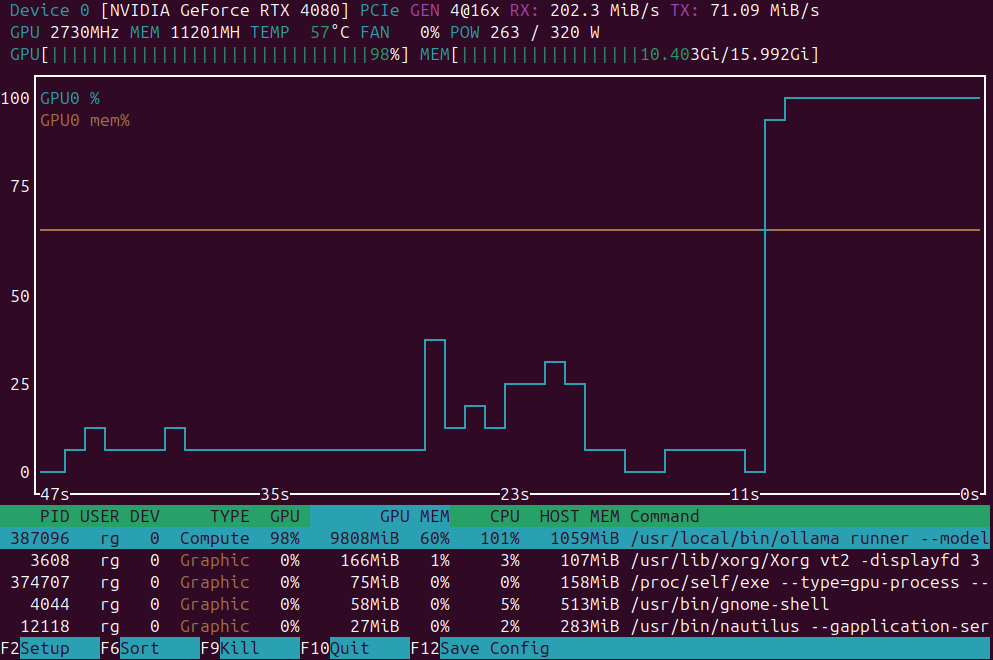

Controllo dei prezzi GPU e RAM di gennaio 2025

Oggi ci concentriamo sui GPU per consumatori di alto livello e sui moduli di RAM. Specificamente sto esaminando prezzi RTX-5080 e RTX-5090, e 32GB (2x16GB) DDR5 6000.