Autoservizio di LLM e Sovranità dell'AI

Controlla dati e modelli con LLM autohostati

L’hosting self-hosted di LLM mantiene i dati, i modelli e l’inferenza sotto il tuo controllo: un percorso pratico verso sovrainità AI per team, aziende e nazioni.

Controlla dati e modelli con LLM autohostati

L’hosting self-hosted di LLM mantiene i dati, i modelli e l’inferenza sotto il tuo controllo: un percorso pratico verso sovrainità AI per team, aziende e nazioni.

Repositori Go più popolari di gennaio 2026

L’ecosistema Go continua a prosperare grazie a progetti innovativi che spaziano dall’AI, alle applicazioni auto-hosted e all’infrastruttura per sviluppatori. Questa panoramica analizza i repository Go più popolari su GitHub di questo mese.

Confronta i migliori strumenti per l'hosting locale di LLM nel 2026. Maturità dell'API, supporto hardware, chiamata degli strumenti e casi d'uso reali.

Eseguire i modelli LLM localmente è ora pratico per sviluppatori, startup e persino team aziendali.

Ma scegliere lo strumento giusto — Ollama, vLLM, LM Studio, LocalAI o altri — dipende dagli obiettivi:

Distribuisci l'AI aziendale su hardware a basso costo con modelli open source

La democratizzazione dell’AI è arrivata. Con modelli open source come Llama 3, Mixtral e Qwen che ora competono con i modelli proprietari, i team possono costruire potenti infrastrutture AI utilizzando hardware consumer - riducendo i costi mentre mantengono il pieno controllo sulla privacy dei dati e sull’implementazione.

Proteggi la tua privacy con avanzate tecnologie anti-fingerprinting

Nel web moderno, la tua identità digitale può essere tracciata senza cookie o consenso esplicito attraverso sofisticate tecniche di fingerprinting digitale.

Sistemi che preservano la privacy con prove a conoscenza zero

Architettura a conoscenza zero rappresenta un cambiamento di paradigma nel modo in cui progettiamo sistemi che preservano la privacy.

Guida completa ai modelli di database multi-tenant

Multi-tenancy è un modello architetturale fondamentale per le applicazioni SaaS, che consente a diversi clienti (inquilini) di condividere la stessa infrastruttura applicativa mantenendo l’isolamento dei dati.

Guida completa alla sicurezza - dati in stato di riposo, in transito, in esecuzione

Quando i dati rappresentano un bene prezioso, garantirne la sicurezza è mai stato più critico.

Dall’istante in cui l’informazione viene creata fino al momento in cui viene eliminata,

il suo percorso è pieno di rischi - sia che venga archiviata, trasferita o utilizzata attivamente.

Controlla i tuoi dati con il cloud storage self-hosted Nextcloud

Nextcloud è la piattaforma di archiviazione e collaborazione cloud open source e autoospitata leader che mette completamente sotto il tuo controllo i tuoi dati.

due potenti sistemi di gestione della conoscenza

Scegliere lo strumento giusto per la Gestione Personale della Conoscenza (PKM) può influenzare in modo significativo la tua produttività, l’apprendimento e l’organizzazione delle informazioni. Vediamo insieme Obsidian e LogSeq.

Le tue foto sul backup alimentato da AI autoospitato

Immich è una soluzione rivoluzionaria, open-source e autoospitata per la gestione di foto e video che ti dà il pieno controllo sui tuoi ricordi. Con funzionalità paragonabili a quelle di Google Photos, tra cui il riconoscimento facciale alimentato dall’intelligenza artificiale, la ricerca intelligente e il backup automatico dal telefono, tutto mantenendo i tuoi dati privati e sicuri sul tuo server.

Protocollo sociale decentralizzato con oltre 21K utenti che sta riformando la privacy online

Ecco qui Nostr - il protocollo sociale decentralizzato che sta sfidando la dominanza del Big Tech con comunicazioni resistenti alla censura e dati controllati dagli utenti.

Esplora motori di ricerca alternativi oltre a Google e Bing

Mentre Google domina il mercato dei motori di ricerca con una quota di mercato globale superiore al 90%, sta crescendo un ecosistema di motori di ricerca alternativi che offrono approcci diversi alla ricerca sul web.

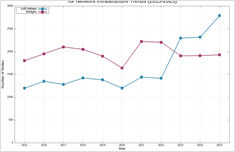

Analisi della crescita e dei challenge della rete Tor nel corso di un decennio

La rete Tor ha sperimentato significative oscillazioni nella sua infrastruttura negli ultimi dieci anni, con uscite e ponti che mostrano pattern distinti di crescita, declino e recupero.

Possiedi il tuo contenuto e controlla la tua identità

Il web era originariamente progettato come una rete decentralizzata in cui chiunque potesse pubblicare e connettersi. Con il tempo, le piattaforme corporative hanno consolidato il controllo, creando giardini recintati in cui gli utenti sono prodotti e il contenuto è bloccato. Il movimento Indie Web mira a ripristinare la promessa originale del web: proprietà personale, libertà creativa e connessione autentica.

Gemini: un'alternativa leggera e sicura al web

Il protocollo Gemini rappresenta un ritorno ai fondamenti della comunicazione su Internet: un’alternativa leggera, sicura e rispettosa della privacy rispetto alla moderna web sempre più complessa.