Guia DORA Metrics: Medindo o Sucesso de DevOps

Mestre as quatro métricas-chave DORA para excelência em DevOps

DORA (DevOps Research and Assessment) métricas são o padrão ouro para medir o desempenho da entrega de software.

Mestre as quatro métricas-chave DORA para excelência em DevOps

DORA (DevOps Research and Assessment) métricas são o padrão ouro para medir o desempenho da entrega de software.

Guia completo sobre padrões de banco de dados multi-tenant

Multi-tenancy é um padrão arquitetural fundamental para aplicações SaaS, permitindo que múltiplos clientes (inquilinos) compartilhem a mesma infraestrutura de aplicação, mantendo a isolamento de dados.

Guia completo de segurança - dados em repouso, em trânsito e em execução

Quando os dados são um ativo valioso, protegê-los nunca foi mais crítico.

Desde o momento em que a informação é criada até o ponto em que é descartada,

sua jornada está repleta de riscos — sejam armazenados, transferidos ou usados ativamente.

Compare headless CMS - funcionalidades, desempenho e casos de uso

Escolher o CMS headless certo pode fazer a diferença no seu estratégia de gestão de conteúdo. Vamos comparar três soluções open-source que influenciam como os desenvolvedores constroem aplicações orientadas por conteúdo.

Desenvolvimento de CLI em Go com os frameworks Cobra e Viper

Aplicações de interface de linha de comandos (CLI) são ferramentas essenciais para desenvolvedores, administradores de sistemas e profissionais de DevOps. Duas bibliotecas Go tornaram-se o padrão de fato para desenvolvimento de CLI em Go: Cobra para estrutura de comandos e Viper para gerenciamento de configuração.

Reduza os custos do LLM em 80% com otimização inteligente de tokens

A otimização de tokens é a habilidade crítica que separa as aplicações de LLM custo-efetivas das experiências que consomem orçamento.

Arquitetura orientada a eventos com AWS Kinesis para escala

AWS Kinesis tornou-se um pilar para a construção de arquiteturas modernas de microserviços orientadas a eventos, permitindo o processamento de dados em tempo real em grande escala com mínimo sobrecusto operacional.

Controle seus dados com o armazenamento em nuvem Nextcloud auto-hospedado

Nextcloud é a principal plataforma de armazenamento e colaboração em nuvem de código aberto e auto-hospedada que coloca você em completo controle dos seus dados.

Suas fotos no backup com IA hospedado localmente

Immich é uma solução revolucionária de gestão de fotos e vídeos de código aberto e auto-hospedada que lhe dá o controle total sobre suas memórias. Com recursos que rivalizam com o Google Photos, incluindo reconhecimento facial impulsionado por IA, pesquisa inteligente e backup automático móvel, tudo isso mantendo seus dados privados e seguros no seu próprio servidor.

Comandos do Elasticsearch para busca, indexação e análise

Elasticsearch é um poderoso motor de busca e análise distribuído construído sobre o Apache Lucene. Este cheatsheet abrangente abrange comandos essenciais, melhores práticas e referências rápidas para trabalhar com clusters Elasticsearch.

Benchmarks do GPT-OSS 120b em três plataformas de IA

Fui atrás de alguns testes de desempenho interessantes do GPT-OSS 120b em execução no Ollama em três plataformas diferentes: NVIDIA DGX Spark, Mac Studio e RTX 4080. O modelo GPT-OSS 120b da biblioteca Ollama tem 65GB, o que significa que ele não cabe na VRAM de 16GB de um RTX 4080 (ou no mais novo RTX 5080).

Testes em Python com pytest, TDD, mocking e coverage

Testes unitários garantem que seu código Python funcione corretamente e continue funcionando conforme seu projeto evolui. Este guia abrangente aborda tudo o que você precisa saber sobre testes unitários em Python, desde conceitos básicos até técnicas avançadas.

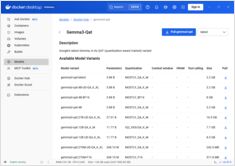

Referência rápida para comandos do Docker Model Runner

Docker Model Runner (DMR) é a solução oficial do Docker para executar modelos de IA localmente, introduzida em abril de 2025. Este guia rápido fornece uma referência rápida para todos os comandos essenciais, configurações e melhores práticas.

Compare Docker Model Runner e Ollama para LLM local

Executar modelos de linguagem grandes (LLMs) localmente tornou-se cada vez mais popular por motivos de privacidade, controle de custos e capacidades offline. O cenário mudou significativamente em abril de 2025, quando o Docker introduziu Docker Model Runner (DMR), sua solução oficial para implantação de modelos de IA.

Implante uma malha de serviço pronta para produção - Istio vs Linkerd

Descubra como implementar e otimizar arquiteturas de malha de serviço usando Istio e Linkerd. Este guia abrange estratégias de implantação, comparações de desempenho, configurações de segurança e melhores práticas para ambientes de produção.

Gerenciamento simples de VM para Linux com GNOME Boxes

No cenário atual da computação, a virtualização tornou-se essencial para desenvolvimento, testes e execução de múltiplos sistemas operacionais. Para usuários de Linux que buscam uma forma simples e intuitiva de gerenciar máquinas virtuais, GNOME Boxes destaca-se como uma opção leve e amigável ao usuário que prioriza a facilidade de uso sem sacrificar a funcionalidade.