Aumentan los precios de las GPU y la RAM en Australia: RTX 5090 sube un 15%, la RAM un 38% - enero de 2026

Verificación de precios de GPU y RAM en enero de 2025

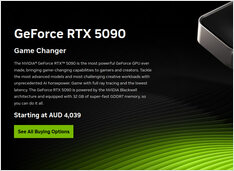

Hoy nos estamos enfocando en las GPUs de consumo de alto nivel y módulos de RAM. Específicamente, me estoy enfocando en precios de RTX-5080 y RTX-5090, y 32GB (2x16GB) DDR5 6000.