Guía de métricas DORA: Medir el éxito de DevOps

Domine las cuatro métricas clave de DORA para la excelencia en DevOps

DORA (DevOps Research and Assessment) métricas son el estándar de oro para medir el rendimiento de la entrega de software.

Domine las cuatro métricas clave de DORA para la excelencia en DevOps

DORA (DevOps Research and Assessment) métricas son el estándar de oro para medir el rendimiento de la entrega de software.

Guía completa sobre patrones de bases de datos multiinquilino

Multi-tenancy es un patrón arquitectónico fundamental para aplicaciones SaaS, permitiendo que múltiples clientes (inquilinos) compartan la misma infraestructura de aplicación mientras mantienen la aislamiento de datos.

Guía completa de seguridad - datos en reposo, en tránsito y en ejecución

Cuando los datos son un activo valioso, garantizar su seguridad nunca ha sido más crítico.

Desde el momento en que la información se crea hasta el punto en que se descarta,

su trayectoria está llena de riesgos, ya sea almacenada, transferida o utilizada activamente.

Compare headless CMS - características, rendimiento y casos de uso

Elegir el CMS sin cabeza adecuado puede marcar la diferencia en tu estrategia de gestión de contenido. Vamos a comparar tres soluciones de código abierto que influyen en cómo los desarrolladores construyen aplicaciones impulsadas por contenido.

Desarrollo de CLI en Go con los marcos Cobra y Viper

Las aplicaciones de interfaz de línea de comandos (CLI) son herramientas esenciales para desarrolladores, administradores de sistemas y profesionales de DevOps.

Dos bibliotecas de Go han se convertido en el estándar de facto para el desarrollo de CLI en Go: Cobra para la estructura de comandos y Viper para la gestión de configuración.

Reduzca los costos de los modelos de lenguaje grande en un 80% con una optimización inteligente de tokens

La optimización de tokens es la habilidad crítica que separa las aplicaciones de LLM eficientes económicamente de experimentos que consumen presupuesto.

Arquitectura orientada a eventos con AWS Kinesis para escalar

AWS Kinesis se ha convertido en un pilar fundamental para construir arquitecturas modernas de microservicios orientadas a eventos, permitiendo el procesamiento en tiempo real de datos a gran escala con un mínimo sobrecoste operativo.

Controla tus datos con el almacenamiento en la nube Nextcloud autohospedado

Nextcloud es la plataforma líder de almacenamiento en la nube y colaboración de código abierto y autohospedada que te da el control total de tus datos.

Sus fotos en la copia de seguridad impulsada por IA alojada en su propio servidor

Immich es una solución revolucionaria de código abierto y autohospedada para la gestión de fotos y videos que te da el control total sobre tus recuerdos. Con características que rivalizan con Google Photos, incluyendo reconocimiento facial impulsado por inteligencia artificial, búsqueda inteligente y copia de seguridad automática desde dispositivos móviles, todo mientras mantienes tus datos privados y seguros en tu propio servidor.

Comandos de Elasticsearch para búsqueda, indexación y análisis

Elasticsearch es un potente motor de búsqueda y análisis distribuido construido sobre Apache Lucene. Este completo resumen de comandos cubre comandos esenciales, mejores prácticas y referencias rápidas para trabajar con clústeres de Elasticsearch.

Resultados de benchmarks de GPT-OSS 120b en tres plataformas de IA

Investigué algunos interesantes tests de rendimiento del modelo GPT-OSS 120b ejecutándose en Ollama en tres plataformas diferentes: NVIDIA DGX Spark, Mac Studio y RTX 4080. El modelo GPT-OSS 120b del repositorio Ollama tiene un tamaño de 65 GB, lo que significa que no cabe en los 16 GB de VRAM de una RTX 4080 (ni en la más reciente RTX 5080).

Pruebas en Python con pytest, TDD, mocking y coverage

La prueba unitaria asegura que tu código en Python funcione correctamente y continúe funcionando a medida que evolucione tu proyecto. Esta guía completa cubre todo lo que necesitas saber sobre pruebas unitarias en Python, desde conceptos básicos hasta técnicas avanzadas.

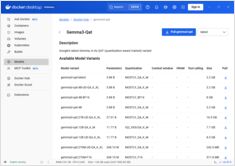

Referencia rápida para comandos de Docker Model Runner

Docker Model Runner (DMR) es la solución oficial de Docker para ejecutar modelos de IA localmente, introducida en abril de 2025. Esta guía rápida proporciona una referencia rápida para todos los comandos esenciales, configuraciones y mejores prácticas.

Compare Docker Model Runner y Ollama para LLM local

Running large language models (LLMs) locally ha ganado popularidad en los últimos tiempos por razones de privacidad, control de costos y capacidades fuera de línea. El panorama cambió significativamente en abril de 2025 cuando Docker introdujo Docker Model Runner (DMR), su solución oficial para la implementación de modelos de IA.

Implementar un service mesh listo para producción - Istio vs Linkerd

Descubre cómo implementar y optimizar arquitecturas de malla de servicios utilizando Istio y Linkerd. Esta guía cubre estrategias de implementación, comparaciones de rendimiento, configuraciones de seguridad y mejores prácticas para entornos de producción.

Gestión sencilla de máquinas virtuales para Linux con GNOME Boxes

En el panorama actual de la computación, la virtualización se ha convertido en esencial para el desarrollo, las pruebas y la ejecución de múltiples sistemas operativos. Para usuarios de Linux que buscan una forma sencilla e intuitiva de gestionar máquinas virtuales, GNOME Boxes destaca como una opción liviana y amigable con el usuario que prioriza la facilidad de uso sin sacrificar la funcionalidad.