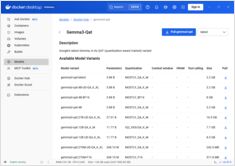

Guía de configuración del tamaño de contexto del Docker Model Runner

Configure tamaños de contexto en Docker Model Runner con soluciones alternativas

Configuración de tamaños de contexto en Docker Model Runner es más compleja de lo que debería ser.

Configure tamaños de contexto en Docker Model Runner con soluciones alternativas

Configuración de tamaños de contexto en Docker Model Runner es más compleja de lo que debería ser.

Modelo de IA para aumentar imágenes con instrucciones de texto

Black Forest Labs ha lanzado FLUX.1-Kontext-dev, un avanzado modelo de inteligencia artificial de imagen a imagen que mejora imágenes existentes mediante instrucciones de texto.

Habilite la aceleración de GPU para Docker Model Runner con soporte de NVIDIA CUDA

Docker Model Runner es la herramienta oficial de Docker para ejecutar modelos de IA localmente, pero habilitar la aceleración de GPU de NVidia en Docker Model Runner requiere una configuración específica.

Reduzca los costos de los modelos de lenguaje grande en un 80% con una optimización inteligente de tokens

La optimización de tokens es la habilidad crítica que separa las aplicaciones de LLM eficientes económicamente de experimentos que consumen presupuesto.

Resultados de benchmarks de GPT-OSS 120b en tres plataformas de IA

Investigué algunos interesantes tests de rendimiento del modelo GPT-OSS 120b ejecutándose en Ollama en tres plataformas diferentes: NVIDIA DGX Spark, Mac Studio y RTX 4080. El modelo GPT-OSS 120b del repositorio Ollama tiene un tamaño de 65 GB, lo que significa que no cabe en los 16 GB de VRAM de una RTX 4080 (ni en la más reciente RTX 5080).

Construya servidores MCP para asistentes de IA con ejemplos en Python

El Protocolo de Contexto del Modelo (MCP) está revolucionando la forma en que los asistentes de IA interactúan con fuentes de datos externas y herramientas. En esta guía, exploraremos cómo construir servidores MCP en Python, con ejemplos centrados en las capacidades de búsqueda en la web y raspado.

Python para convertir HTML en Markdown limpio y listo para LLM

Convertir HTML a Markdown es una tarea fundamental en los flujos de trabajo de desarrollo modernos, especialmente cuando se prepara contenido web para Modelos de Lenguaje Grande (LLMs), sistemas de documentación o generadores de sitios estáticos como Hugo.

Referencia rápida para comandos de Docker Model Runner

Docker Model Runner (DMR) es la solución oficial de Docker para ejecutar modelos de IA localmente, introducida en abril de 2025. Esta guía rápida proporciona una referencia rápida para todos los comandos esenciales, configuraciones y mejores prácticas.

Compare Docker Model Runner y Ollama para LLM local

Running large language models (LLMs) locally ha ganado popularidad en los últimos tiempos por razones de privacidad, control de costos y capacidades fuera de línea. El panorama cambió significativamente en abril de 2025 cuando Docker introdujo Docker Model Runner (DMR), su solución oficial para la implementación de modelos de IA.

Los chips especializados están haciendo que la inferencia de IA sea más rápida y económica.

El futuro de IA no es solo sobre modelos más inteligentes modelos — es sobre silicio más inteligente.

El hardware especializado para inferencia de LLM está impulsando una revolución similar a la transición del minado de Bitcoin hacia los ASICs.

Disponibilidad, precios minoristas reales en seis países y comparación con Mac Studio.

NVIDIA DGX Spark es real, disponible para la venta el 15 de octubre de 2025, y está dirigido a desarrolladores de CUDA que necesitan realizar trabajo local con LLM con una pila de IA integrada de NVIDIA. Precio de venta al por mayor en EE. UU. $3,999; el precio de venta al por menor en Reino Unido/DE/JP es más alto debido al IVA y al canal. Los precios públicos en AUD/KRW aún no están ampliamente publicados.

Comparando la velocidad, parámetros y rendimiento de estos dos modelos

Aquí hay una comparación entre Qwen3:30b y GPT-OSS:20b enfocada en el seguimiento de instrucciones y parámetros de rendimiento, especificaciones y velocidad:

Ejemplos Específicos Utilizando Modelos de Lenguaje Pensantes

En este artículo, exploraremos dos formas de conectar su aplicación Python con Ollama: 1. A través del API REST HTTP; 2. A través de la biblioteca oficial de Ollama para Python.

No muy agradable.

Los modelos GPT-OSS de Ollama tienen problemas recurrentes al manejar salidas estructuradas, especialmente cuando se usan con marcos como LangChain, OpenAI SDK, vllm y otros.

Las APIs ligeramente diferentes requieren un enfoque especial.

Aquí tienes una comparación de soporte lado a lado de salida estructurada (obtener JSON confiable) entre proveedores populares de LLM, más ejemplos mínimos en Python

Un par de formas de obtener salida estructurada de Ollama

Modelos de Lenguaje Grande (LLMs) son poderosos, pero en producción raramente queremos párrafos libres. En su lugar, queremos datos predecibles: atributos, hechos u objetos estructurados que puedas alimentar en una aplicación. Eso es Salida Estructurada de LLM.