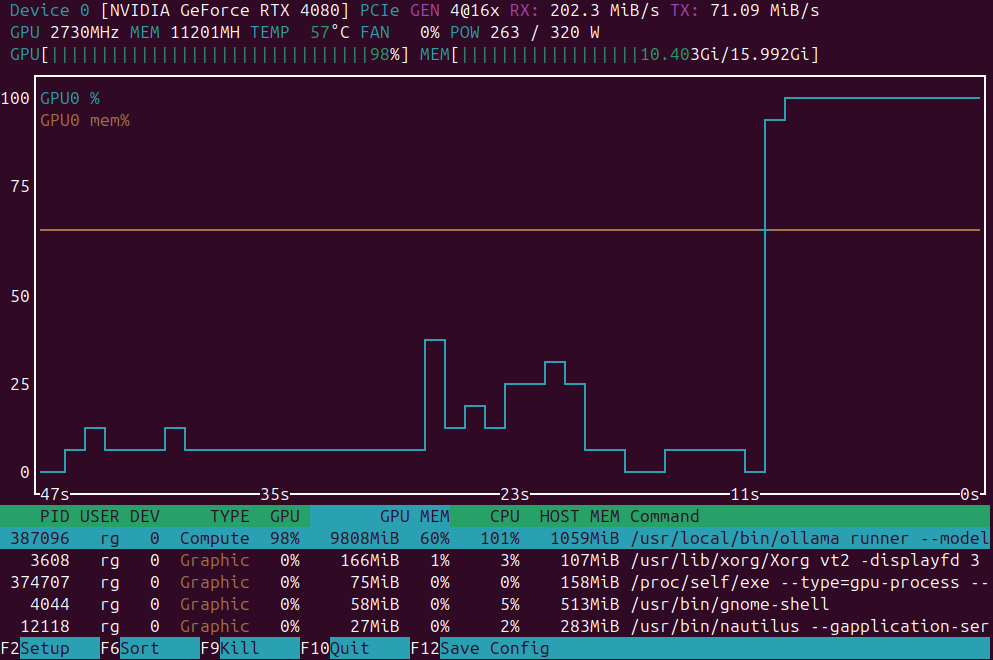

Problèmes de sortie structurée d'Ollama GPT-OSS

Peu agréable.

Les modèles GPT-OSS d’Ollama présentent régulièrement des problèmes pour gérer les sorties structurées, surtout lorsqu’ils sont utilisés avec des cadres comme LangChain, OpenAI SDK, vllm et d’autres.