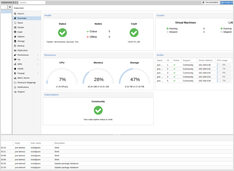

NVIDIA DGX Spark vs Mac Studio vs RTX-4080: Ollama-prestatielijst

GPT-OSS 120b benchmarks op drie AI-platforms

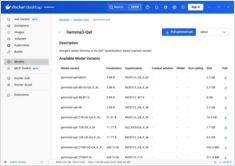

Ik vond enkele interessante prestatietests van GPT-OSS 120b die draaien op Ollama over drie verschillende platforms: NVIDIA DGX Spark, Mac Studio, en RTX 4080. De GPT-OSS 120b model uit de Ollama bibliotheek weegt 65 GB, wat betekent dat het niet past in de 16 GB VRAM van een RTX 4080 (of de nieuwere RTX 5080).