Przewodnik po metrykach DORA: pomiar sukcesu DevOps

Zdobądź wiedzę na temat czterech kluczowych metryk DORA dla doskonałości w DevOpsie

DORA (DevOps Research and Assessment) metryki są standardem dla oceny wydajności dostarczania oprogramowania.

Zdobądź wiedzę na temat czterech kluczowych metryk DORA dla doskonałości w DevOpsie

DORA (DevOps Research and Assessment) metryki są standardem dla oceny wydajności dostarczania oprogramowania.

Kompletny przewodnik po wzorcach baz danych wielodostępowych

Multi-tenancy to fundamentalny wzorzec architektoniczny dla aplikacji SaaS, umożliwiający wielu klientom (najemcom) współdzielone korzystanie z tej samej infrastruktury aplikacji, przy jednoczesnym utrzymaniu izolacji danych.

Kompletny przewodnik po zabezpieczeniach – dane w spoczynku, w trakcie przesyłania i w czasie wykonywania

Kiedy dane są cennym zasobem, ich ochrona nigdy nie była bardziej krytyczna.

Od momentu, gdy informacje są tworzone, aż do momentu, gdy są usuwane,

ich podróż jest pełna ryzyk – czy to przechowywane, przesyłane, czy aktywnie wykorzystywane.

Porównaj headless CMS – funkcje, wydajność i przypadki użycia

Wybór odpowiedniego headless CMS może zdecydować o sukcesie lub porażce Twojej strategii zarządzania treścią. Porównajmy trzy rozwiązania open source, które wpływają na to, jak programiści budują aplikacje oparte na treści.

Rozwój CLI w Go z użyciem frameworków Cobra i Viper

Interfejs wiersza poleceń (CLI) to istotne narzędzia dla programistów, administratorów systemów oraz specjalistów DevOps.

Dwie biblioteki w języku Go stały się standardem dla rozwoju CLI w Go: Cobra do struktury poleceń i Viper do zarządzania konfiguracją.

Zredukuj koszty LLM o 80% dzięki inteligentnej optymalizacji tokenów

Optymalizacja tokenów to kluczowe umiejętności, które oddzielają kosztowne aplikacje LLM od doświadczeń zużycia budżetu.

Architektura oparta na zdarzeniach z użyciem AWS Kinesis do skalowania

AWS Kinesis stał się fundamentem dla budowania nowoczesnych architektur mikroserwisów opartych na wydarzeniach, umożliwiając przetwarzanie danych w czasie rzeczywistym na dużą skalę z minimalnym nakładem operacyjnym.

Zarządzaj swoimi danymi za pomocą samodzielnie hostowanego magazynu Nextcloud

Nextcloud to lider otwartego źródła, samodzielnie hostowanego rozwiązania do przechowywania i współpracy w chmurze, które daje Ci pełną kontrolę nad swoimi danymi.

Twoje zdjęcia w samodzielnej, AI-opartej kopii zapasowej

Immich to rewolucyjne, open-source, samozostawiające się rozwiązanie do zarządzania zdjęciami i filmami, które daje Ci pełną kontrolę nad swoimi wspomnieniami. Dzięki funkcjom równorzędnym Google Photos, w tym AI-powered rozpoznawaniu twarzy, inteligentnemu wyszukiwaniu i automatycznemu backupowi z telefonu, wszystko to, przy jednoczesnym zachowaniu prywatności i bezpieczeństwa danych na Twoim własnym serwerze.

Polecenia Elasticsearch do wyszukiwania, indeksowania i analizy

Elasticsearch to potężny rozproszony silnik wyszukiwania i analizy danych oparty na Apache Lucene. Ta kompletna lista poleceń obejmuje istotne polecenia, najlepsze praktyki oraz szybkie odniesienia do pracy z klastrami Elasticsearch.

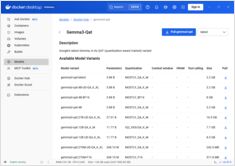

Wyniki testów GPT-OSS 120b na trzech platformach AI

Testowanie w Pythonie z użyciem pytest, TDD, mockowanie i pokrycie kodu

Testowanie jednostkowe zapewnia, że Twoja kod w Pythonie działa poprawnie i nadal działa, gdy projekt ewoluuje. Ten kompleksowy przewodnik pokrывает wszystko, co musisz wiedzieć na temat testowania jednostkowego w Pythonie, od podstawowych pojęć po zaawansowane techniki.

Szybki przewodnik po poleceniach Docker Model Runner

Docker Model Runner (DMR) to oficjalne rozwiązanie firmy Docker do uruchamiania modeli AI lokalnie, wprowadzone w kwietniu 2025 roku. Ten cheatsheet zawiera szybki przewodnik po wszystkich istotnych komendach, konfiguracjach i najlepszych praktykach.

Porównaj Docker Model Runner i Ollama dla lokalnego LLM

Uruchamianie dużych modeli językowych (LLM) lokalnie staje się coraz bardziej popularne ze względu na prywatność, kontrolę kosztów i możliwości offline. Landscape zmienił się znacząco w kwietniu 2025 roku, gdy Docker wprowadził Docker Model Runner (DMR), oficjalne rozwiązanie do wdrażania modeli AI.

Wdrożenie gotowego do produkcji sieci usług - Istio vs Linkerd

Odkryj, jak zaimplementować i zoptymalizować architektury sieci usług przy użyciu Istio i Linkerd. Niniejszy przewodnik obejmuje strategie wdrażania, porównania wydajności, konfiguracje bezpieczeństwa oraz najlepsze praktyki dla środowisk produkcyjnych.

Prosta obsługa maszyn wirtualnych dla Linuxa z GNOME Boxes

W obecnej sytuacji informatycznej wirtualizacja stała się nieodzowna dla rozwoju, testowania i uruchamiania wielu systemów operacyjnych. Dla użytkowników systemu Linux poszukujących prostego i intuicyjnego sposobu zarządzania maszynami wirtualnymi, GNOME Boxes wyróżnia się jako lekki i przyjazny dla użytkownika wybór, który priorytetyzuje łatwość użycia bez poświęcania funkcjonalności.