Docker Model Runner: Przewodnik konfiguracji rozmiaru kontekstu

Skonfiguruj rozmiary kontekstu w Docker Model Runner z użyciem zaokrągleń

Konfigurowanie rozmiarów kontekstu w Docker Model Runner jest bardziej skomplikowane, niż powinno być.

Skonfiguruj rozmiary kontekstu w Docker Model Runner z użyciem zaokrągleń

Konfigurowanie rozmiarów kontekstu w Docker Model Runner jest bardziej skomplikowane, niż powinno być.

Model AI do wzbogacania obrazów za pomocą instrukcji tekstowych

Black Forest Labs wydała FLUX.1-Kontext-dev, zaawansowany model AI przekształcający obrazy na podstawie instrukcji tekstowych.

Włącz przyspieszenie GPU dla Docker Model Runner z obsługą NVIDIA CUDA

Docker Model Runner to narzędzie oficjalne Dockera do uruchamiania modeli AI lokalnie, ale włączanie przyspieszenia GPU od firmy NVidia w Docker Model Runner wymaga konkretnej konfiguracji.

Zredukuj koszty LLM o 80% dzięki inteligentnej optymalizacji tokenów

Optymalizacja tokenów to kluczowe umiejętności, które oddzielają kosztowne aplikacje LLM od doświadczeń zużycia budżetu.

Wyniki testów GPT-OSS 120b na trzech platformach AI

Tworzenie serwerów MCP dla asystentów AI z przykładami w Pythonie

Protokół Kontekstu Modelu (MCP) rewolucjonizuje sposób, w jaki asystenci AI interagują z zewnętrznymi źródłami danych i narzędziami. W tym przewodniku omówimy, jak zbudować serwery MCP w Pythonie, z przykładami skupionymi na możliwościach wyszukiwania w sieci i skrapowania.

Python do konwersji HTML na czysty, gotowy do użycia przez LLM Markdown

Konwersja HTML na Markdown to podstawowe zadanie w współczesnych przepływach pracy programistycznych, szczególnie przygotowując treści internetowe do Large Language Models (LLM), systemów dokumentacji lub generatorów stron statycznych takich jak Hugo.

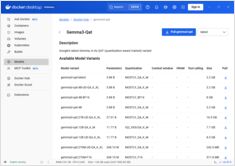

Szybki przewodnik po poleceniach Docker Model Runner

Docker Model Runner (DMR) to oficjalne rozwiązanie firmy Docker do uruchamiania modeli AI lokalnie, wprowadzone w kwietniu 2025 roku. Ten cheatsheet zawiera szybki przewodnik po wszystkich istotnych komendach, konfiguracjach i najlepszych praktykach.

Porównaj Docker Model Runner i Ollama dla lokalnego LLM

Uruchamianie dużych modeli językowych (LLM) lokalnie staje się coraz bardziej popularne ze względu na prywatność, kontrolę kosztów i możliwości offline. Landscape zmienił się znacząco w kwietniu 2025 roku, gdy Docker wprowadził Docker Model Runner (DMR), oficjalne rozwiązanie do wdrażania modeli AI.

Specjalistyczne procesory sprawiają, że wnioskowanie w AI jest szybsze i tańsze.

Przyszłość AI nie jest tylko o bardziej inteligentne modele – jest o bardziej inteligentny krzem.

Specjalistyczne sprzęty do wyznaczania wyników LLM napędzają rewolucję podobną do przejścia od wydobywania bitcoina do ASICów.

Dostępność, rzeczywiste ceny detaliczne na terenie sześciu krajów oraz porównanie z Mac Studio.

NVIDIA DGX Spark jest rzeczywisty, dostępny do zakupu 15 października 2025 roku, i skierowany do programistów CUDA, którzy potrzebują lokalnej pracy z LLM zintegrowanej z NVIDIA AI stack. Cena MSRP w Stanach Zjednoczonych to $3 999; UK/DE/JP ma wyższą cenę detaliczną z powodu VAT i kanałów. AUD/KRW publiczne ceny są jeszcze nie powszechnie opublikowane.

Porównanie prędkości, parametrów i wydajności tych dwóch modeli

Oto porównanie między Qwen3:30b a GPT-OSS:20b skupiające się na przestrzeganiu instrukcji i parametrach wydajności, specyfikacjach oraz prędkości:

+ Konkretne Przykłady Używania Myślących LLMów

W tym wpisie omówimy dwa sposoby łączenia swojej aplikacji Python z Ollama: 1. Poprzez HTTP REST API; 2. Poprzez oficjalną bibliotekę Pythona dla Ollama.

Nie bardzo przyjemne.

Modele GPT-OSS z Ollama mają powtarzające się problemy z obsługą strukturalnego wyjścia, zwłaszcza gdy są używane wraz z frameworkami takimi jak LangChain, OpenAI SDK, vllm i innymi.

Slightly different APIs require special approach. Slightly different APIs require special approach.

Oto porównanie wsparcia w formie obok siebie dla strukturalnego wyjścia (otrzymywanie niezawodnego JSON) wśród popularnych dostawców LLM, wraz z minimalnymi przykładami w Pythonie

Kilka sposobów na uzyskanie strukturalnego wyjścia z Ollama

Duże modele językowe (LLMs)

są potężne, ale w środowisku produkcyjnym rzadko chcemy wolnych paragrafów.

Zamiast tego chcemy przewidywalne dane: atrybuty, fakty lub strukturalne obiekty, które można przekazać do aplikacji.

To Strukturalne wyjście LLM.