Docker Model Runner: Guia de Configuração do Tamanho do Contexto

Configure tamanhos de contexto no Docker Model Runner com soluções alternativas

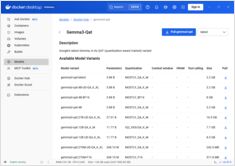

Configurar tamanhos de contexto no Docker Model Runner é mais complexo do que deveria ser.

Configure tamanhos de contexto no Docker Model Runner com soluções alternativas

Configurar tamanhos de contexto no Docker Model Runner é mais complexo do que deveria ser.

Modelo de IA para aumentar imagens com instruções de texto

Black Forest Labs lançou FLUX.1-Kontext-dev, um avançado modelo de IA de imagem para imagem que aumenta imagens existentes usando instruções de texto.

Habilite a aceleração da GPU para o Docker Model Runner com suporte à NVIDIA CUDA

Docker Model Runner é a ferramenta oficial do Docker para executar modelos de IA localmente, mas habilitar a aceleração da GPU da NVidia no Docker Model Runner requer uma configuração específica.

Reduza os custos do LLM em 80% com otimização inteligente de tokens

A otimização de tokens é a habilidade crítica que separa as aplicações de LLM custo-efetivas das experiências que consomem orçamento.

Benchmarks do GPT-OSS 120b em três plataformas de IA

Fui atrás de alguns testes de desempenho interessantes do GPT-OSS 120b em execução no Ollama em três plataformas diferentes: NVIDIA DGX Spark, Mac Studio e RTX 4080. O modelo GPT-OSS 120b da biblioteca Ollama tem 65GB, o que significa que ele não cabe na VRAM de 16GB de um RTX 4080 (ou no mais novo RTX 5080).

Construa servidores MCP para assistentes de IA com exemplos em Python

O Protocolo de Contexto do Modelo (MCP) está revolucionando a forma como os assistentes de IA interagem com fontes de dados externas e ferramentas. Neste guia, exploraremos como construir servidores MCP em Python, com exemplos focados nas capacidades de busca na web e raspagem.

Python para converter HTML em Markdown limpo e pronto para LLM

Conversão de HTML para Markdown é uma tarefa fundamental nos fluxos de trabalho modernos de desenvolvimento, especialmente ao preparar conteúdo web para Grandes Modelos de Linguagem (LLMs), sistemas de documentação ou geradores de sites estáticos como o Hugo.

Referência rápida para comandos do Docker Model Runner

Docker Model Runner (DMR) é a solução oficial do Docker para executar modelos de IA localmente, introduzida em abril de 2025. Este guia rápido fornece uma referência rápida para todos os comandos essenciais, configurações e melhores práticas.

Compare Docker Model Runner e Ollama para LLM local

Executar modelos de linguagem grandes (LLMs) localmente tornou-se cada vez mais popular por motivos de privacidade, controle de custos e capacidades offline. O cenário mudou significativamente em abril de 2025, quando o Docker introduziu Docker Model Runner (DMR), sua solução oficial para implantação de modelos de IA.

Chipsets especializados estão tornando a inferência de IA mais rápida e barata.

O futuro do IA não é apenas sobre modelos mais inteligentes modelos — é sobre silício mais inteligente.

Hardware especializado para inferência de LLM está impulsionando uma revolução semelhante à mudança do mineração de Bitcoin para ASICs.

Disponibilidade, preços reais no varejo em seis países e comparação com o Mac Studio.

NVIDIA DGX Spark é real, disponível para venda a partir de 15 de outubro de 2025, e direcionado a desenvolvedores de CUDA que precisam de trabalho local com LLM com uma pilha integrada de IA da NVIDIA. Preço de venda sugerido nos EUA $3.999; o preço retalhista em UK/DE/JP é mais alto devido ao imposto sobre o valor agregado e ao canal. Preços públicos em AUD/KRW ainda não estão amplamente divulgados.

Comparando velocidade, parâmetros e desempenho desses dois modelos

Aqui está uma comparação entre Qwen3:30b e GPT-OSS:20b

focando em seguir instruções e parâmetros de desempenho, especificações e velocidade:

Exemplos Específicos Utilizando Modelos de Linguagem Pensantes

Neste post, vamos explorar duas maneiras de conectar sua aplicação Python ao Ollama: 1. Via API REST HTTP; 2. Via a biblioteca oficial do Ollama para Python.

Não muito agradável.

Modelos GPT-OSS do Ollama têm problemas recorrentes ao lidar com saídas estruturadas, especialmente quando usados com frameworks como LangChain, OpenAI SDK, vllm e outros.

APIs ligeiramente diferentes exigem uma abordagem especial.

Aqui está uma comparação lado a lado de suporte para saída estruturada (obter JSON confiável de volta) entre provedores populares de LLM, juntamente com exemplos mínimos de Python

Alguns modos de obter saída estruturada do Ollama

Grandes Modelos de Linguagem (LLMs) são poderosos, mas, em produção, raramente queremos parágrafos livres. Em vez disso, queremos dados previsíveis: atributos, fatos ou objetos estruturados que você pode alimentar em um aplicativo. Isso é Saída Estruturada de LLM.