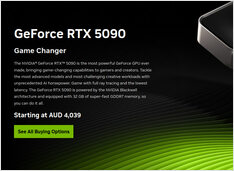

GPU- und RAM-Preise in Australien steigen: RTX 5090 um 15 % erhöht, RAM um 38 % - Januar 2026

GPU- und RAM-Preiskontrolle Januar 2025

Heute untersuchen wir die Top-Level-Verbraucher-GPUs und RAM-Module. Speziell betrachte ich die Preise für RTX-5080 und RTX-5090 sowie 32GB (2x16GB) DDR5 6000.