KI-Infrastruktur auf Consumer-Hardware

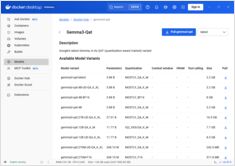

Enterprise-KI auf Budget-Hardware mit Open-Modellen einsetzen

Die Demokratisierung von KI ist da. Mit Open-Source-LLMs wie Llama 3, Mixtral und Qwen, die nun mit proprietären Modellen mithalten, können Teams leistungsstarke KI-Infrastruktur mit Consumer-Hardware aufbauen - Kosten senken, während sie die vollständige Kontrolle über Datenschutz und Bereitstellung behalten.