Docker 모델 러너에 NVIDIA GPU 지원 추가

NVIDIA CUDA를 지원하는 Docker 모델 러너에 GPU 가속 기능을 활성화하세요.

Docker Model Runner은 로컬에서 AI 모델을 실행하기 위한 Docker의 공식 도구이지만, NVIDIA GPU 가속을 Docker Model Runner에서 활성화하기 위해서는 특정한 설정이 필요합니다.

NVIDIA CUDA를 지원하는 Docker 모델 러너에 GPU 가속 기능을 활성화하세요.

Docker Model Runner은 로컬에서 AI 모델을 실행하기 위한 Docker의 공식 도구이지만, NVIDIA GPU 가속을 Docker Model Runner에서 활성화하기 위해서는 특정한 설정이 필요합니다.

제로識 증명을 이용한 개인정보 보호 시스템

제로지식 아키텍처는 개인정보 보호 시스템을 설계하는 방식에 있어 패러다임의 변화를 의미합니다.

완전한 보안 가이드 - 정지 상태, 전송 중, 실행 중 데이터

데이터가 귀중한 자산일 때, 이를 보호하는 것이 지금까지보다 더 중요해졌습니다. 정보가 생성되는 순간부터 폐기되는 순간까지, 그 여정은 저장, 전송, 또는 활발히 사용되는 동안 위험에 노출될 수 있습니다. 저장, 전송, 또는 활발히 사용하는 동안 데이터는 다양한 위험에 직면하게 됩니다.

헤드리스 CMS 비교 - 기능, 성능 및 사용 사례

올바른 헤드리스 CMS를 선택하는 것은 콘텐츠 관리 전략을 성공적으로 만들거나 망하게 만들 수 있습니다.

개발자가 콘텐츠 중심 애플리케이션을 구축하는 방식에 영향을 미치는 세 가지 오픈소스 솔루션을 비교해 보겠습니다.

Go에서 Cobra와 Viper 프레임워크를 사용한 CLI 개발

명령줄 인터페이스(CLI) 애플리케이션은 개발자, 시스템 관리자, DevOps 전문가에게 필수적인 도구입니다. Go 언어로 CLI 개발을 수행하는 데 사용되는 두 가지 라이브러리인 Cobra(명령 구조)와 Viper(구성 관리)가 표준이 되었습니다.

스마트 토큰 최적화로 LLM 비용을 80% 절감하세요

토큰 최적화는 예산을 소모하는 실험에서 비용 효율적인 LLM(대규모 언어 모델) 애플리케이션을 구분하는 핵심 기술입니다.

확장성을 위한 AWS Kinesis를 활용한 이벤트 주도 아키텍처

AWS Kinesis은 현대적인 이벤트 기반 마이크로서비스 아키텍처를 구축하는 데 핵심적인 역할을 하며, 최소한의 운영 부담으로 대규모 실시간 데이터 처리를 가능하게 해줍니다.

GraphQL BFF와 Apollo Server를 사용하여 프론트엔드 API 최적화

프론트엔드를 위한 백엔드(BFF) 패턴을 GraphQL과 Apollo Server와 결합하면 현대 웹 애플리케이션에 강력한 아키텍처를 구축할 수 있습니다.

검색, 인덱싱 및 분석을 위한 Elasticsearch 명령어

Elasticsearch은 Apache Lucene 기반의 강력한 분산 검색 및 분석 엔진입니다.

이 포괄적인 체크리스트는 Elasticsearch 클러스터와 함께 작업할 때 필수 명령어, 최선의 실천 방법, 그리고 빠른 참조를 다룹니다.

AI 어시스턴트를 위한 MCP 서버를 Python 예제와 함께 구축하세요.

모델 컨텍스트 프로토콜(MCP)은 AI 어시스턴트가 외부 데이터 소스 및 도구와 상호 작용하는 방식을 혁신하고 있습니다. 이 가이드에서는 웹 검색 및 스크래핑 기능에 초점을 맞춘 MCP 서버를 Python으로 구축 방법을 살펴보겠습니다.

Docker Model Runner 명령어의 빠른 참조

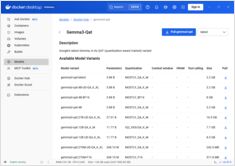

Docker 모델 러너 (DMR)는 2025년 4월에 도입된 Docker의 공식 솔루션으로, 로컬에서 AI 모델을 실행하는 데 사용됩니다. 이 체크리스트는 모든 필수 명령어, 구성 및 최선의 실천 방법에 대한 빠른 참조를 제공합니다.

도커 모델 러너와 올라마를 사용한 로컬 LLM 비교

로컬에서 대규모 언어 모델(LLM) 실행 는 프라이버시, 비용 관리, 오프라인 기능을 위해 점점 더 인기를 끌고 있습니다. 2025년 4월에 Docker가 Docker Model Runner (DMR), AI 모델 배포를 위한 공식 솔루션을 발표하면서 상황은 크게 변화했습니다.

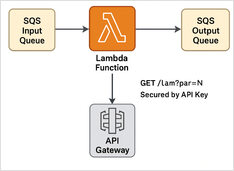

단계별 예시

여기에서 SQS 메시지 처리기의 Python Lambda 예제 + API 키 보호 기능이 있는 REST API와 함께 Terraform 스크립트를 사용하여 서버리스 실행을 위해 배포할 수 있습니다.

+ Thinking LLMs를 사용한 구체적인 예시

이 게시물에서는 Python 애플리케이션을 Ollama에 연결하는 두 가지 방법을 살펴보겠습니다: 1. HTTP REST API를 통해; 2. 공식 Ollama Python 라이브러리를 통해.

조금 다른 API는 특별한 접근이 필요합니다.

다음은 구조화된 출력을 지원하는 주요 LLM 제공업체 간의 비교 및 최소한의 Python 예제입니다.