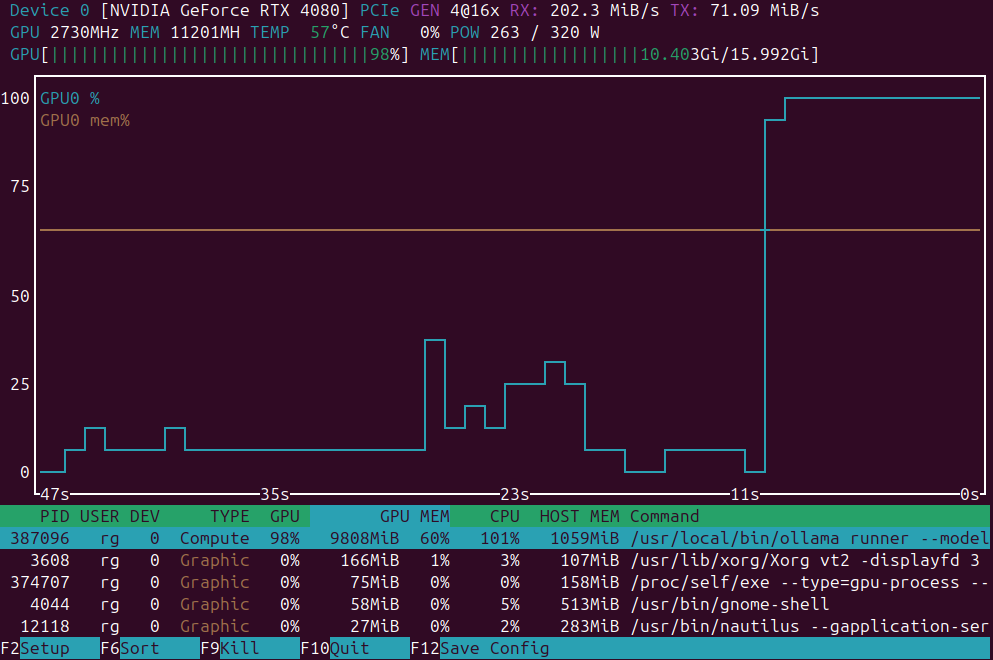

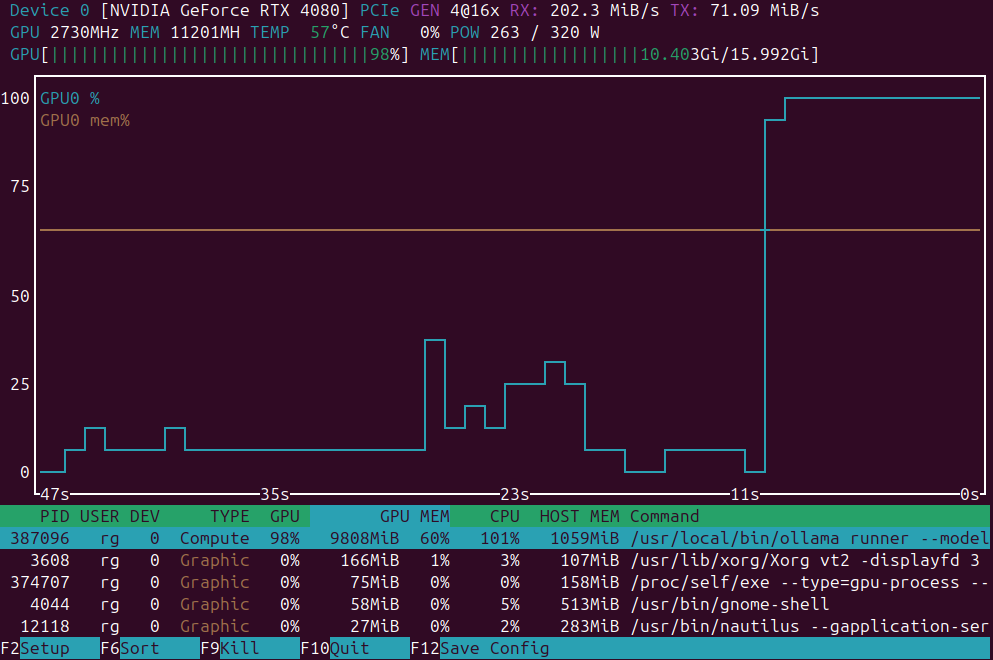

Aplicativos de monitoramento de GPU no Linux / Ubuntu

Pequena lista de aplicações para monitoramento de carga da GPU

Aplicações de monitoramento de carga da GPU:

nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

Pequena lista de aplicações para monitoramento de carga da GPU

Aplicações de monitoramento de carga da GPU:

nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.

Instalando o pequeno k3s Kubernetes em um cluster de homelab

Aqui está um passo a passo para a instalação de um cluster K3s com 3 nós em servidores de metal nu (1 mestre + 2 trabalhadores).

Breve visão geral das variantes do Kubernetes

Comparando distribuições de self-hosting Kubernetes para hospedagem em servidores bare-metal ou domésticos, com foco na facilidade de instalação, desempenho, requisitos do sistema e conjuntos de recursos.

Escolhendo a melhor versão do Kubernetes para o nosso homelab

Estou comparando variantes de Kubernetes auto-hospedado que se adequam ao homelab baseado no Ubuntu com 3 nós (16 GB de RAM, 4 núcleos cada), focando na facilidade de instalação e manutenção, suporte para volumes persistentes e LoadBalancers.

Um pouco sobre as ações comuns do GitHub e sua estrutura.

GitHub Actions é uma plataforma de automação e CI/CD dentro do GitHub, usada para construir, testar e implantar seu código com base em eventos como pushes, pull requests ou em um agendamento.

Por sinal, docker-compose é diferente de docker compose...

Aqui está uma

Docker Compose cheatsheet

com exemplos anotados para ajudá-lo a dominar os arquivos e comandos do Compose rapidamente.

Sobre o Obsidian ...

Aqui está uma análise detalhada de

Obsidian como uma ferramenta poderosa para gestão do conhecimento pessoal (GKP),

explicando sua arquitetura, funcionalidades, vantagens e como apoia fluxos de trabalho modernos de conhecimento.

Em julho de 2025, em breve deverá estar disponível

Nvidia está prestes a lançar NVIDIA DGX Spark - pequeno supercomputador de IA baseado na arquitetura Blackwell com 128+GB de memória unificada e 1 PFLOPS de desempenho de IA. Dispositivo interessante para executar LLMs.

Quais sistemas de análise de web utilizar em seu site?

Vamos dar uma rápida olhada em Matomo, Plausible, google e outros provedores e sistemas de análise web disponíveis para auto-hospedagem e compará-los.

Notas sobre a sequência padrão de instalação do Ubuntu 24.04

Aqui está meu conjunto favorito de passos ao fazer instalação limpa do Ubuntu 24.04. O que eu gosto aqui é que não é necessário instalar drivers da NVidia! Eles são instalados automaticamente.

Estava usando o Dokuwiki como uma base de conhecimento pessoal

Dokuwiki é um wikipedia auto-hospedado que pode ser hospedado facilmente no local e não requer nenhum banco de dados. Estava executando-o dockerizado, no meu cluster kubernetes pessoal.

Atualização de preços de GPU adequada para IA - RTX 5080 e RTX 5090

Vamos comparar preços para GPUs de topo de linha para consumidores, que são adequadas para LLMs em particular e para IA em geral. Especificamente, dê uma olhada em preços da RTX 5080 e RTX 5090. Eles tiveram uma leve queda.

Bom framework para ETS/MLOPS com Python

Apache Airflow é uma plataforma de código aberto projetada para autorizar, agendar e monitorar fluxos de trabalho de forma programática, totalmente em código Python, oferecendo uma alternativa flexível e poderosa aos ferramentas tradicionais, manuais ou baseadas em interface gráfica de fluxos de trabalho.

Implementando RAG? Aqui estão alguns trechos de código em Go - 2...

Como o Ollama padrão não possui uma API de rerank direta, você precisará implementar reranking usando o Qwen3 Reranker em GO gerando embeddings para pares de consulta-documento e classificando-os.

qwen3 8b, 14b e 30b, devstral 24b, mistral small 24b

Neste teste, estou comparando como diferentes LLMs hospedados no Ollama traduzem páginas Hugo do inglês para o alemão. Três páginas que testei estavam sobre temas diferentes, tinham alguma marcação markdown com alguma estrutura: cabeçalhos, listas, tabelas, links, etc.

Implementando RAG? Aqui estão alguns trechos de código em Golang.

Este pequeno exemplo de código Go para reranking está chamando o Ollama para gerar embeddings para a consulta e para cada documento candidato, em seguida, classificando em ordem decrescente pela similaridade do cosseno.