Мониторинг инференса LLM в продакшене (2026): Prometheus и Grafana для vLLM, TGI, llama.cpp

Мониторинг LLM с помощью Prometheus и Grafana

Мониторинг LLM с помощью Prometheus и Grafana

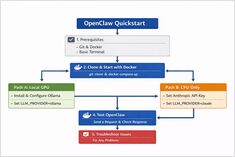

Установите OpenClaw локально с Ollama

OpenClaw — это самоуправляемый AI-ассистент, предназначенный для работы с локальными LLM-движками, такими как Ollama, или с облачными моделями, такими как Claude Sonnet.

Обзор и сравнение AWS S3, Garage и MinIO.

AWS S3 остается “стандартным” базовым решением для объектного хранения: это полностью управляемая, сильно согласованная система, разработанная для чрезвычайно высокой долговечности и доступности. Garage и MinIO — это самонастраиваемые альтернативы, совместимые с S3: Garage предназначен для легковесных, геораспределенных кластеров малого и среднего размера, в то время как MinIO делает акцент на широком покрытии API S3 и высокой производительности в крупных развертываниях.

Запустите Garage в Docker за несколько минут

Гараж — это открытое, саморазмещаемое, совместимое с S3 объектное хранилище, предназначенное для небольших и средних развертываний с акцентом на устойчивость и геораспределение.

Управляйте данными и моделями с помощью саморазмещаемых ЛЛМ

Самостоятельное размещение LLM позволяет контролировать данные, модели и выводы — это практический путь к суверенитету ИИ для команд, предприятий и стран.

Тест скорости LLM на RTX 4080 с 16 ГБ видеопамяти

Запуск крупных языковых моделей локально обеспечивает вам конфиденциальность, возможность работы оффлайн и отсутствие затрат на API. Этот бенчмарк раскрывает, чего именно можно ожидать от 14 популярных LLMs на Ollama на RTX 4080.

Трендовые Go-репозитории января 2026

Экосистема Go продолжает процветать с инновационными проектами, охватывающими инструменты ИИ, самоуправляемые приложения и инфраструктуру разработчиков. Этот обзор анализирует самые популярные репозитории Go на GitHub в этом месяце.

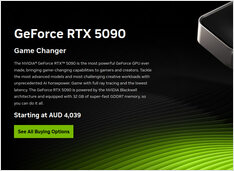

Проверка цен на GPU и RAM в январе 2025 года

Сегодня мы рассматриваем топовые потребительские графические процессоры и модули оперативной памяти. Конкретно я смотрю на цены на RTX-5080 и RTX-5090, а также на 32ГБ (2x16ГБ) DDR5 6000.

Самостоятельно развёртываемая альтернатива ChatGPT для локальных моделей большого языка

Открыть WebUI — это мощное, расширяемое и функциональное веб-приложение для взаимодействия с большими языковыми моделями.

Быстрая инференция LLM с использованием API OpenAI

vLLM — это высокопроизводительный, энергоэффективный движок для инференса и обслуживания больших языковых моделей (LLM), разработанный лабораторией Sky Computing Университета Калифорнии в Беркли.

Актуальные цены на AUD у австралийских ритейлеров

NVIDIA DGX Spark (GB10 Grace Blackwell) теперь доступен в Австралии в местных магазинах у крупных розничных продавцов ПК с наличием на складе. Если вы следили за глобальными ценами и доступностью DGX Spark, вам будет интересно узнать, что цены в Австралии составляют от 6 249 до 7 999 AUD в зависимости от конфигурации хранилища и продавца.

Тестирование Cognee с локальными ЛЛМ - реальные результаты

Cognee — это фреймворк на Python для создания знаний из документов с использованием LLMs. Но работает ли он с самонастраиваемыми моделями?

Размышления об использовании больших языковых моделей для саморазмещаемого Cognee

Выбор лучшей LLM для Cognee требует баланса между качеством построения графов, уровнями галлюцинаций и ограничениями оборудования. Cognee лучше всего работает с крупными моделями с низким уровнем галлюцинаций (32B+) через Ollama, но средние варианты подходят для более легких настроек.

AI-поисковые агенты с помощью Python и Ollama

Библиотека Python для Ollama теперь включает в себя нативные возможности поиска в интернете с Ollama. С несколькими строками кода вы можете дополнить свои локальные LLMs актуальной информацией из интернета, снижая вероятность галлюцинаций и повышая точность.

Выберите подходящую векторную базу данных для вашего стека RAG

Выбор правильного векторного хранилища может существенно повлиять на производительность, стоимость и масштабируемость вашего приложения RAG. Это всестороннее сравнение охватывает наиболее популярные варианты в 2024-2025 годах.