DORA-Metriken-Leitfaden: DevOps-Erfolg messen

Meistern Sie die vier zentralen DORA-Metriken für DevOps-Exzellenz

DORA (DevOps Research and Assessment) Metriken sind der Goldstandard zur Messung der Software-Lieferleistung.

Meistern Sie die vier zentralen DORA-Metriken für DevOps-Exzellenz

DORA (DevOps Research and Assessment) Metriken sind der Goldstandard zur Messung der Software-Lieferleistung.

Vollständiger Leitfaden zu Multi-Tenancy-Datenbankmustern

Multi-Tenancy ist ein grundlegendes Architektur-Muster für SaaS-Anwendungen, das mehreren Kunden (Mietern) ermöglicht, dieselbe Anwendungsinfrastruktur zu teilen, während die Datenisolation aufrechterhalten wird.

Vollständiger Sicherheitsleitfaden - Daten in Ruhe, im Transit, zur Laufzeit

Wenn Daten ein wertvolles Gut sind, war ihre Sicherung noch nie so entscheidend. Vom Zeitpunkt der Erstellung bis zum Zeitpunkt der Entsorgung ist ihre Reise mit Risiken behaftet - ob gespeichert, übertragen oder aktiv genutzt.

Vergleichen Sie headless CMS - Funktionen, Leistung & Anwendungsfälle

Die Wahl der richtigen headless CMS kann über den Erfolg Ihrer Content-Management-Strategie entscheiden. Lassen Sie uns drei Open-Source-Lösungen vergleichen, die den Aufbau von contentgetriebenen Anwendungen beeinflussen.

CLI-Entwicklung in Go mit den Frameworks Cobra und Viper

Kommandzeilen-Interface (CLI)-Anwendungen sind essentielle Werkzeuge für Entwickler, Systemadministratoren und DevOps-Professionals. Zwei Go-Bibliotheken haben sich als de facto Standard für CLI-Entwicklung in Go: Cobra für die Befehlsstruktur und Viper für das Konfigurationsmanagement.

Senken Sie die LLM-Kosten um 80 % mit intelligenter Token-Optimierung

Tokenoptimierung ist die kritische Fähigkeit, die kosteneffiziente LLM-Anwendungen von budgetbelastenden Experimenten unterscheidet.

Ereignisgesteuerte Architektur mit AWS Kinesis für Skalierbarkeit

AWS Kinesis ist zu einem Eckpfeiler für den Aufbau moderner ereignisgesteuerter Mikroservice-Architekturen geworden, die eine Echtzeit-Datenverarbeitung im großen Maßstab mit minimalem Betriebsaufwand ermöglichen.

Kontrollieren Sie Ihre Daten mit der selbstgehosteten Nextcloud-Cloud-Speicherlösung

Nextcloud ist die führende Open-Source-, Self-Hosting-Cloud-Speicher- und Kollaborationsplattform, die Sie vollständig in den Besitz Ihrer Daten bringt.

Ihre Fotos auf selbstgehostetem KI-gestütztem Backup

Immich ist eine revolutionäre Open-Source-Lösung für die selbstgehostete Verwaltung von Fotos und Videos, die Ihnen die vollständige Kontrolle über Ihre Erinnerungen gibt. Mit Funktionen, die denen von Google Photos in nichts nachstehen – einschließlich KI-gestützter Gesichtserkennung, intelligenter Suche und automatischer Mobilgeräte-Sicherung – und dabei Ihre Daten privat und sicher auf Ihrem eigenen Server halten.

Elasticsearch-Befehle für Suche, Indexierung und Analysen

Elasticsearch ist ein leistungsstarkes verteiltes Such- und Analyse-Engine, das auf Apache Lucene basiert. Dieses umfassende Cheat-Sheet behandelt wesentliche Befehle, Best Practices und schnelle Referenzen für die Arbeit mit Elasticsearch-Clustern.

GPT-OSS 120b Benchmarks auf drei KI-Plattformen

Ich habe einige interessante Leistungsuntersuchungen zu GPT-OSS 120b ausgegraben, das auf Ollama auf drei verschiedenen Plattformen läuft: NVIDIA DGX Spark, Mac Studio und RTX 4080. Das GPT-OSS 120b-Modell aus der Ollama-Bibliothek wiegt 65 GB, was bedeutet, dass es nicht in die 16 GB VRAM einer RTX 4080 (oder der neueren RTX 5080) passt.

Python-Tests mit pytest, TDD, Mocking und Abdeckung

Unit testing stellt sicher, dass Ihr Python-Code korrekt funktioniert und weiterhin funktioniert, wenn sich Ihr Projekt weiterentwickelt. Diese umfassende Anleitung behandelt alles, was Sie über Unit Testing in Python wissen müssen, von grundlegenden Konzepten bis hin zu fortgeschrittenen Techniken.

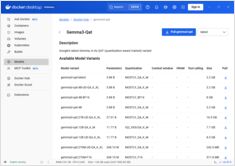

Schnelle Referenz für Docker Model Runner-Befehle

Docker Model Runner (DMR) ist die offizielle Lösung von Docker zum lokalen Ausführen von KI-Modellen, eingeführt im April 2025. Dieses Cheatblatt bietet eine schnelle Referenz für alle wesentlichen Befehle, Konfigurationen und Best Practices.

Vergleichen Sie Docker Model Runner und Ollama für lokale LLMs

Lokales Ausführen großer Sprachmodelle (LLMs) ist aufgrund von Datenschutz, Kostenkontrolle und Offline-Fähigkeiten immer beliebter geworden. Die Landschaft veränderte sich im April 2025 erheblich, als Docker Docker Model Runner (DMR) einführte, seine offizielle Lösung für die Bereitstellung von KI-Modellen.

Bereitstellen eines produktionsreifen Service Mesh - Istio vs. Linkerd

Entdecken Sie, wie Sie Service-Mesh-Architekturen mit Istio und Linkerd implementieren und optimieren. Dieser Leitfaden behandelt Bereitstellungsstrategien, Leistungsvergleiche, Sicherheitskonfigurationen und Best Practices für Produktionsumgebungen.

Einfaches VM-Management für Linux mit GNOME Boxes

In der heutigen Rechenlandschaft ist Virtualisierung für Entwicklung, Tests und den Betrieb mehrerer Betriebssysteme unverzichtbar. Für Linux-Nutzer, die eine einfache und intuitive Möglichkeit suchen, virtuelle Maschinen zu verwalten, sticht GNOME Boxes als leichtgewichtige und benutzerfreundliche Option hervor, die Benutzerfreundlichkeit ohne Funktionalität zu opfern.