DGX Spark vs. Mac Studio: Preisgeprüfter Vergleich von NVIDIAs persönlichem KI-Supercomputer

Verfügbarkeit, tatsächliche Einzelhandelspreise in sechs Ländern und Vergleich mit dem Mac Studio.

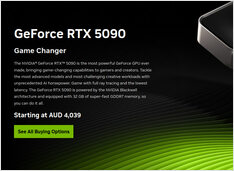

NVIDIA DGX Spark ist real, erhältlich ab dem 15. Oktober 2025 und richtet sich an CUDA-Entwickler, die lokale LLM-Arbeit mit einem integrierten NVIDIA AI-Stack benötigen. US-MSRP 3.999 $; UK/DE/JP Einzelhandel ist aufgrund von Mehrwertsteuer und Vertrieb höher. AUD/KRW öffentliche Preise sind noch nicht weit verbreitet.