オーストラリアでGPUとRAMの価格が上昇:RTX 5090は15%、RAMは38%上昇 - 2026年1月

2025年1月GPUおよびRAM価格チェック

今日、トップレベルの消費者向けGPUとRAMモジュールについて見てみましょう。

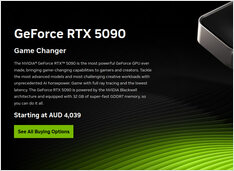

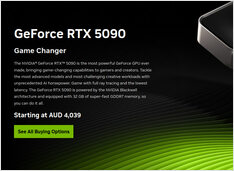

特に注目しているのは、RTX-5080およびRTX-5090の価格と、32GB(2x16GB)DDR5 6000です。

2025年1月GPUおよびRAM価格チェック

今日、トップレベルの消費者向けGPUとRAMモジュールについて見てみましょう。

特に注目しているのは、RTX-5080およびRTX-5090の価格と、32GB(2x16GB)DDR5 6000です。

今やオーストラリアの小売業者から実際のAUD価格が提供されています。

NVIDIA DGX Spark (GB10 Grace Blackwell)は オーストラリアで今すぐ購入可能 の主要PC小売店で在庫あり。

グローバルDGX Sparkの価格と入手方法を ご存知の方は、オーストラリアの価格がストレージ構成や小売店によって 6,249〜7,999オーストラリアドル と幅があることをご存知でしょう。

Ubuntuでネットワークの問題を解決した方法

新しいカーネルを自動インストールした後、Ubuntu 24.04でイーサネットネットワークが失われたという問題が発生しました。この面倒な問題は私にとって2度目だったので、同じ問題に直面している他の人々の助けになるよう、ここに解決策を記録しています。

短い投稿ですが、価格を記録しておきます。

この異常なRAM価格の変動を理解し、より明確な見通しを持つために、まずは自分たちでオーストラリアのRAM価格を追跡しましょう。

RAM価格がAI需要による供給圧力で163〜619%上昇

2025年後半にかけて、メモリ市場はかつてない価格のボラティリティに直面しています。すべてのセグメントにわたってRAMの価格が急騰しており、RAM価格の急騰が深刻な状況となっています。

AIに最適な消費者向けGPUの価格 - RTX 5080およびRTX 5090

トップレベルの消費者向けGPUの価格を比較してみましょう。特にLLM(大規模言語モデル)に適しており、AI全般にも適しています。具体的には以下を確認しています。

予算のハードウェアでオープンモデルを使用して企業向けAIを展開

AIの民主化はここにあります。 Llama 3、Mixtral、QwenなどのオープンソースLLMが、今やプロプライエタリモデルと同等の性能を発揮するようになり、チームは消費者ハードウェアを使用して強力なAIインフラストラクチャを構築できるようになりました。これにより、コストを削減しながらも、データプライバシーやデプロイメントに関する完全なコントロールを維持することが可能です。

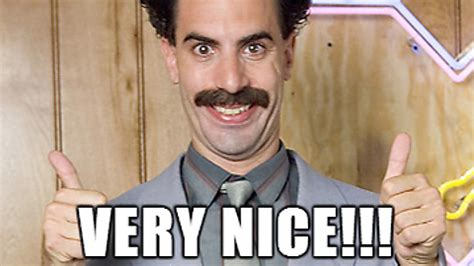

NVIDIA CUDAをサポートするDocker Model RunnerでGPU加速を有効にする

Docker Model Runner は、AIモデルをローカルで実行するためのDocker公式ツールですが、NVIDIA GPU加速をDocker Model Runnerで有効にする には特定の設定が必要です。

GPT-OSS 120bの3つのAIプラットフォームでのベンチマーク

Docker Model Runner コマンドのクイックリファレンス

Docker Model Runner (DMR) は、2025年4月に導入されたDocker公式のAIモデルをローカルで実行するためのソリューションです。このチートシートは、すべての必須コマンド、設定、ベストプラクティスのクイックリファレンスを提供しています。

GNOME Boxes による Linux 用のシンプルな仮想マシン管理

現代のコンピューティング環境において、仮想化は開発、テスト、複数のオペレーティングシステムの実行において不可欠となっています。Linuxユーザーが仮想マシンを簡単に管理できる方法を探している場合、GNOME Boxesは、機能性を犠牲にすることなく、軽量で使いやすいオプションとして際立っています。

専用チップにより、AIの推論がより高速かつ低コストになってきている。

在庫状況、6か国の実際の小売価格、およびMac Studioとの比較。

NVIDIA DGX Spark は現実のものであり、2025年10月15日に販売開始され、CUDA開発者向けに、統合されたNVIDIA AIスタックを使用してローカルLLM作業を行う必要がある人を対象としています。US MSRPは**$3,999**; UK/DE/JPの小売価格はVATとチャネルの影響で高くなっています。AUD/KRWの公開価格はまだ広く掲載されていません。

プロクシマックスとは何か?

Proxmox Virtual Environment (Proxmox VE) は、Debian 上に構築されたオープンソースのタイプ1ハイパバーリザーバーおよびデータセンターのオーケストレーションプラットフォームです。

AIに最適な消費者向けGPUの価格 - RTX 5080およびRTX 5090

またまた、LLM(大規模言語モデル)に特に、AI全般に適した上位レベルの消費者向けGPUの価格を比較してみましょう。具体的には、以下を確認しています。

RTX-5080およびRTX-5090の価格

価格はわずかに下がっています。

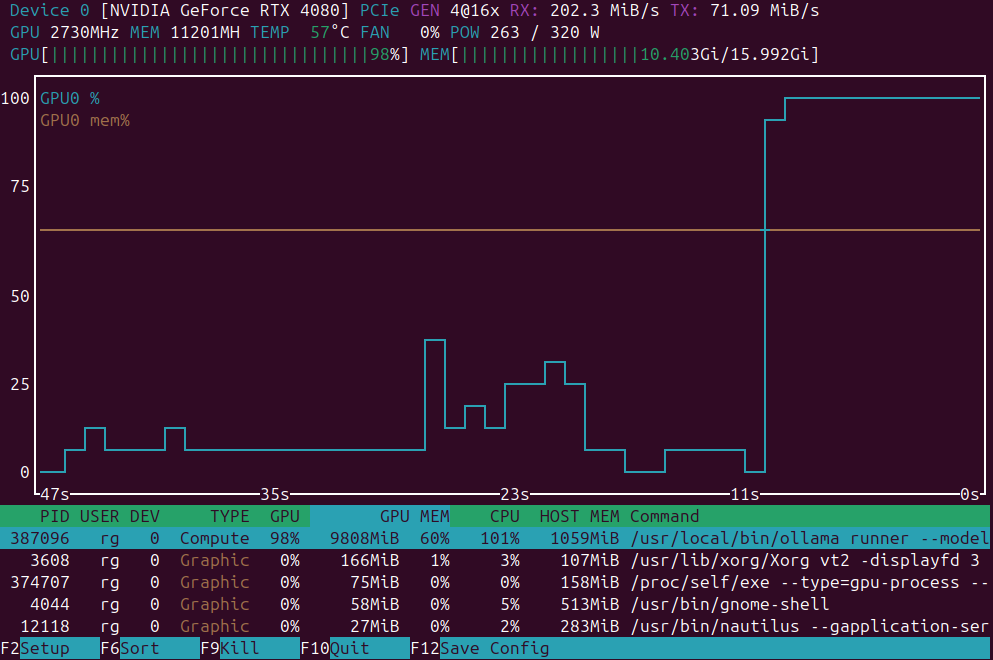

GPU負荷監視用のアプリケーションの簡単な一覧

GPU負荷監視アプリケーション: nvidia-smi vs nvtop vs nvitop vs KDE plasma systemmonitor.