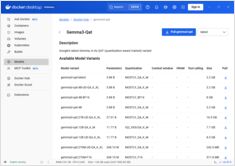

DockerモデルランナーにNVIDIA GPUサポートを追加する

NVIDIA CUDAをサポートするDocker Model RunnerでGPU加速を有効にする

Docker Model Runner は、AIモデルをローカルで実行するためのDocker公式ツールですが、NVIDIA GPU加速をDocker Model Runnerで有効にする には特定の設定が必要です。

NVIDIA CUDAをサポートするDocker Model RunnerでGPU加速を有効にする

Docker Model Runner は、AIモデルをローカルで実行するためのDocker公式ツールですが、NVIDIA GPU加速をDocker Model Runnerで有効にする には特定の設定が必要です。

ゼロ知識証明を用いたプライバシー保護システム

ゼロ知識アーキテクチャ(https://www.glukhov.org/ja/post/2025/11/zero-knowledge-architecture/ “ゼロ知識アーキテクチャ”)は、プライバシーを保つシステムを設計する方法に革命をもたらすパラダイムシフトを表しています。

完全なセキュリティガイド - 保存中のデータ、転送中のデータ、実行中のデータ

データが貴重な資産である現代において、その保護はこれまでになく重要性を増しています。情報が作成される瞬間から廃棄されるまで、その旅は常にリスクに満ちています。保存、転送、または積極的に使用されるデータに関わらず、それぞれに固有の課題と解決策があります。

ヘッドレスCMSの比較 - 機能、パフォーマンスおよびユースケース

正しい ヘッドレス CMS の選択は、コンテンツ管理戦略を成功させるか、失敗させるかを左右します。 開発者がコンテンツ駆動型アプリケーションを構築する方法に影響を与える3つのオープンソースソリューションを比較してみましょう。

GoでCobraとViperフレームワークを使用したCLI開発

コマンドラインインターフェース(CLI)アプリケーションは、開発者、システム管理者、DevOpsプロフェッショナルにとって不可欠なツールです。 Go言語でCLIを開発するための2つのライブラリが、CLI開発におけるGoの標準として広く採用されています:コマンド構造にはCobra、設定管理にはViper。

LLMのコストを80%削減するスマートなトークン最適化で

トークン最適化は、コスト効率の良いLLMアプリケーションから予算を圧迫する実験を分ける重要なスキルです。

スケーラビリティに優れたAWS Kinesisを活用したイベント駆動型アーキテクチャ

AWS Kinesis は、現代のイベント駆動型マイクロサービスアーキテクチャを構築するための基盤として、最小限の運用負荷で大規模なリアルタイムデータ処理を可能にしています。

GraphQL BFF と Apollo Server を使用してフロントエンド API を最適化する

Backend for Frontend (BFF) パターンをGraphQLとApollo Serverと組み合わせることで、現代のウェブアプリケーションに強力なアーキテクチャを構築できます。

検索、インデクシングおよび分析用のElasticsearchコマンド

Elasticsearch は、Apache Lucene に基づいて構築された強力な分散型検索および分析エンジンです。 この包括的なチートシートでは、Elasticsearch クラスターを使用する際の必須コマンド、ベストプラクティス、およびクイックリファレンスをカバーしています。

Pythonの例を使ってAIアシスタント用のMCPサーバーを構築する

モデルコンテキストプロトコル(MCP)は、AIアシスタントが外部データソースやツールとどのように相互作用するかを革命的に変えてきました。本ガイドでは、ウェブ検索およびスクレイピング機能に焦点を当てた例を用いて、MCPサーバーをPythonで構築する方法について説明します。

Docker Model Runner コマンドのクイックリファレンス

Docker Model Runner (DMR) は、2025年4月に導入されたDocker公式のAIモデルをローカルで実行するためのソリューションです。このチートシートは、すべての必須コマンド、設定、ベストプラクティスのクイックリファレンスを提供しています。

Docker Model RunnerとOllamaを用いたローカルLLMの比較

ローカルで大規模言語モデル(LLM)を実行する は、プライバシー、コスト管理、オフライン機能のため、ますます人気になっています。 2025年4月にDockerがDocker Model Runner(DMR)、AIモデルの展開用公式ソリューションを導入したことで、状況は大きく変わりました。

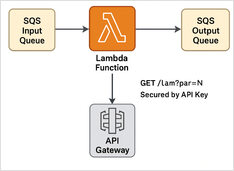

ステップバイステップの例

ここに、Python LambdaのSQSメッセージプロセッサの例 + REST APIとAPIキー保護 + Terraformスクリプトがあり、サーバーレス実行のためにそれをデプロイします。

+ 思考型LLMを使用した具体的な例

この投稿では、PythonアプリケーションをOllamaに接続する方法について2つの方法を紹介します。1つ目はHTTP REST APIを介して、2つ目は公式のOllama Pythonライブラリを介して行います。

わずかに異なるAPIには特別なアプローチが必要です。

以下は、提供されたHugoページコンテンツの日本語への翻訳です。すべてのHugoショートコードと技術要素は正確に保持されており、日本語の文法、表記、文化に合った表現が使用されています。

以下は、構造化された出力(信頼性の高いJSONを取得)をサポートする、人気のあるLLMプロバイダーの比較、および最小限のPythonの例です。