DIY印刷プランナーインサート - 3つの方法

自宅でカスタムプランナーインサートを印刷する際のポイント

アナログな計画の満足感とデジタルデザインツールの柔軟性を組み合わせたカスタムプランナーインサートの作成は、非常に魅力的です。ここでは印刷に関するいくつかのメモを紹介します。

自宅でカスタムプランナーインサートを印刷する際のポイント

アナログな計画の満足感とデジタルデザインツールの柔軟性を組み合わせたカスタムプランナーインサートの作成は、非常に魅力的です。ここでは印刷に関するいくつかのメモを紹介します。

簡潔な説明と私の結果

この投稿は、私のバーベキューの蛇の形に並べた炭 の美しい写真を紹介するためのものです。火をつける準備ができています。

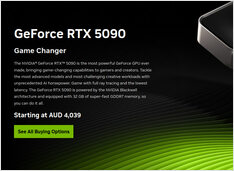

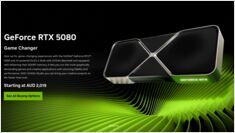

AIに最適な消費者向けGPUの価格 - RTX 5080およびRTX 5090

トップレベルの消費者向けGPUの価格を比較してみましょう。特にLLM(大規模言語モデル)に適しており、AI全般にも適しています。具体的には以下を確認しています。

予算のハードウェアでオープンモデルを使用して企業向けAIを展開

AIの民主化はここにあります。 Llama 3、Mixtral、QwenなどのオープンソースLLMが、今やプロプライエタリモデルと同等の性能を発揮するようになり、チームは消費者ハードウェアを使用して強力なAIインフラストラクチャを構築できるようになりました。これにより、コストを削減しながらも、データプライバシーやデプロイメントに関する完全なコントロールを維持することが可能です。

2つの強力な知識管理システム

正しいパーソナル・ノウハウ・マネジメント(PKM)ツールの選択は、あなたの生産性、学習、情報整理に大きな影響を与えることができます。では、ObsidianとLogSeqを見てみましょう。

AIに最適な消費者向けGPUの価格 - RTX 5080およびRTX 5090

またまた、LLM(大規模言語モデル)に特に、AI全般に適した上位レベルの消費者向けGPUの価格を比較してみましょう。具体的には、以下を確認しています。

RTX-5080およびRTX-5090の価格

価格はわずかに下がっています。

MiKTeX と TeX Live と TinyTeX

Windows上で技術文書、論文、または本を執筆する場合、ほぼ確実に以下の3つのLaTeXディストリビューションのいずれかを選択することになります:

Obsidianについて……

以下は、提供されたHugoページコンテンツの日本語への翻訳です。すべての技術的なフォーマット、構造、Hugo固有の要素は保持されています。

以下は、Obsidianが**個人知識管理(PKM)**に強力なツールとしてどのように機能するかの詳細な解説です。Obsidian as a powerful tool for personal knowledge management (PKM)。そのアーキテクチャ、機能、強み、そして現代の知識ワークフローをどのようにサポートするかについて説明しています。

個人的知识管理の概要と使用可能なシステム

ここに、パーソナル・ノウハウ・マネジメントの概要、目的、方法、そして2025年7月この素晴らしい日に使用できるソフトウェアシステムについて紹介します。

私はDokuwikiを個人的な知識ベースとして使用していました。

Dokuwikiは、データベースを必要とせず、オンプレミスで簡単にホストできるセルフホスト型のウィキパediaです。

私は、ペットのKubernetesクラスター上でDocker化してDokuwikiを運用していました。

AIに最適なGPU価格の更新 - RTX 5080およびRTX 5090

トップレベルの消費者向けGPUの価格を比較しましょう。特にLLM(大規模言語モデル)やAI全体に適したGPUについて詳しく見てみましょう。

具体的には、RTX 5080およびRTX 5090の価格を見てみましょう。わずかに価格が下がっています。

RAGを実装中ですか?ここにGoのコードの一部 - 2...

標準的な Ollama には直接のリランク API がありませんので、 クエリとドキュメントのペアに対して埋め込みを生成し、それらをスコアリングすることで、Qwen3 リランカーを使用したリランキング(GO 言語で) を実装する必要があります。

RAGを実装中ですか?Golangでのコードスニペットの例をいくつか紹介します。

この小さな Reranking Goコード例はOllamaを呼び出して埋め込みを生成しています クエリと各候補ドキュメントに対して、 その後、コサイン類似度で降順にソートします。

価格の現実チェック - RTX 5080 と RTX 5090

ちょうど3か月前には、RTX 5090は店頭に並んでいなかったが、今やそれらが販売されている。ただし、価格はMRSPよりもやや高くなっている。

最も安いオーストラリアでのRTX 5080およびRTX 5090の価格を比較してみよう。

レシピのメモ:小さなメートルの調理方法

Keeping this here for the list of ingredients and inspiration - リスソール.

より多くのRAM、より少ない電力消費、それでもなお高価な……

トップの自動化システムで、ある素晴らしい仕事に使用されます。