PythonでFLUX.1-dev GGUF Q8を実行しています

GGUF量子化でFLUX.1-devを高速化

FLUX.1-dev は、驚くほど美しい画像を生成できる強力なテキストから画像生成モデルですが、24GB以上のメモリが必要なため、多くのシステムでは実行が難しいです。 GGUF量化されたFLUX.1-dev は、メモリ使用量を約50%削減しながらも、優れた画像品質を維持するという解決策を提供します。

GGUF量子化でFLUX.1-devを高速化

FLUX.1-dev は、驚くほど美しい画像を生成できる強力なテキストから画像生成モデルですが、24GB以上のメモリが必要なため、多くのシステムでは実行が難しいです。 GGUF量化されたFLUX.1-dev は、メモリ使用量を約50%削減しながらも、優れた画像品質を維持するという解決策を提供します。

Docker Model Runnerでコンテキストサイズを設定する方法と回避策

ドッカー・モデル・ランナーでのコンテキストサイズの設定は、本来よりも複雑です。

テキスト指示を使って画像を拡張するためのAIモデル

ブラックフォレスト・ラボズは、FLUX.1-Kontext-devという高度な画像から画像へのAIモデルをリリースしました。このモデルは、テキストの指示を使って既存の画像を補強します。

NVIDIA CUDAをサポートするDocker Model RunnerでGPU加速を有効にする

Docker Model Runner は、AIモデルをローカルで実行するためのDocker公式ツールですが、NVIDIA GPU加速をDocker Model Runnerで有効にする には特定の設定が必要です。

ヘッドレスCMSの比較 - 機能、パフォーマンスおよびユースケース

正しい ヘッドレス CMS の選択は、コンテンツ管理戦略を成功させるか、失敗させるかを左右します。 開発者がコンテンツ駆動型アプリケーションを構築する方法に影響を与える3つのオープンソースソリューションを比較してみましょう。

自社ホスティング可能なNextcloudクラウドストレージでデータをコントロールしましょう

Nextcloud は、データを完全に自身のコントロール下に置くことができる、オープンソースで自己ホスティング可能なクラウドストレージおよび協働プラットフォームのリーディングカンパニーです。

ご自身でホストするAIを活用したバックアップに使用される写真

Immich は、あなたの思い出を完全にコントロールできる、革新的なオープンソースでセルフホスト型の写真および動画管理ソリューションです。Google Photos と競合する機能を備えており、AI による顔認識、スマート検索、自動モバイルバックアップを含みながら、あなたのデータをプライバシーとセキュリティを保ったまま、あなたのサーバー上に保管します。

検索、インデクシングおよび分析用のElasticsearchコマンド

Elasticsearch は、Apache Lucene に基づいて構築された強力な分散型検索および分析エンジンです。 この包括的なチートシートでは、Elasticsearch クラスターを使用する際の必須コマンド、ベストプラクティス、およびクイックリファレンスをカバーしています。

GPT-OSS 120bの3つのAIプラットフォームでのベンチマーク

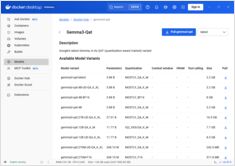

Docker Model Runner コマンドのクイックリファレンス

Docker Model Runner (DMR) は、2025年4月に導入されたDocker公式のAIモデルをローカルで実行するためのソリューションです。このチートシートは、すべての必須コマンド、設定、ベストプラクティスのクイックリファレンスを提供しています。

Docker Model RunnerとOllamaを用いたローカルLLMの比較

ローカルで大規模言語モデル(LLM)を実行する は、プライバシー、コスト管理、オフライン機能のため、ますます人気になっています。 2025年4月にDockerがDocker Model Runner(DMR)、AIモデルの展開用公式ソリューションを導入したことで、状況は大きく変わりました。

GNOME Boxes による Linux 用のシンプルな仮想マシン管理

現代のコンピューティング環境において、仮想化は開発、テスト、複数のオペレーティングシステムの実行において不可欠となっています。Linuxユーザーが仮想マシンを簡単に管理できる方法を探している場合、GNOME Boxesは、機能性を犠牲にすることなく、軽量で使いやすいオプションとして際立っています。

マルチパスのインストール、設定、および基本的なコマンド

Multipass は、Linux、Windows、macOS で Ubuntu クラウドインスタンスを作成および管理するのに役立つ軽量な仮想マシンマネージャです。

グーグルやバイング以外の代替の検索エンジンを探してみましょう

グーグルがグローバル市場シェアの90%以上を占める検索エンジン市場を支配している一方で、代替検索エンジンという成長中のエコシステムが、ウェブ検索に異なるアプローチを提供しています。

専用チップにより、AIの推論がより高速かつ低コストになってきている。

コンテンツを所有し、アイデンティティをコントロールしましょう

ウェブはもともと、誰でも公開し、接続できる分散型ネットワークとして設計されていました。しかし、時間が経つにつれて、企業のプラットフォームが権限を集中させ、ユーザーが製品となり、コンテンツがロックインされるウォールド・ガーデンを作り出しました。Indie Web movementは、ウェブの元々の約束を復活させることを目指しています:個人所有、創造の自由、そして本物のつながり。